KI-Videomodelle werden zunehmend besser, die Qualität ihres Outputs hängt bekanntlich jedoch stark von dem Videomaterial ab, anhand dessen sie lernen, wie Videos auszusehen haben. Womit werden sie also trainiert? Bei dieser Frage halten sich alle KI-Anbieter (außer Adobe) bedeckt - OpenAIs CTO Mira Murati etwa sagte in einem Interview, man habe im Internet frei verfügbares oder lizensiertes Material genutzt.

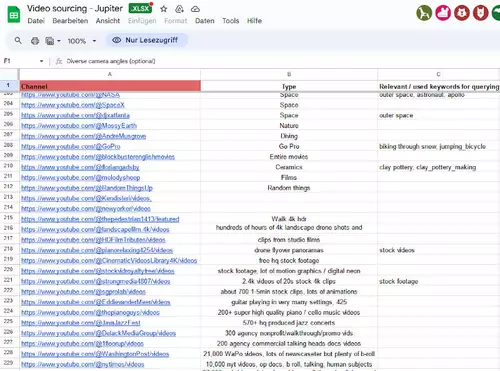

Wie das Magazin 404 nun recherchiert hat, wurde die neueste Gen-3 des mit Sora konkurrierenden Videomodells Runway offensichtlich u.a. mit speziell ausgesuchten, hochqualitativen YouTube-Videos trainiert. Diese Informationen stammen von einem ehemaligen Runway-Mitarbeiter und werden von einer mehrseitigen Tabelle ("Video sourcing - Jupiter", letzteres soll der Codename für Gen-3 gewesen sein) untermauert, in der tausende YouTube-Clips und -Kanäle von Runway-Angestellten gelistet, verschlagwortet und bewertet wurden. Um welche Art Video es sich handelt (Aerial, Travel, Gaming, Musikvideo...) und was darin zu sehen ist - Inhalte wie Natur, Architektur etc. oder Tätigkeiten wie abspülen, Fahrrad reparieren, Salsa tanzen usw. - wurde akribisch erfasst.

Denn nicht nur muss ein Videomodell in der Lage sein, überzeugende Bilder zu generieren, sondern eine Voraussetzung dafür ist ja auch, dass es "versteht", was jeweils errechnet werden soll. Dafür sind Bildbeschreibungen extrem wichtig, aus denen das Modell Verknüpfungen zwischen Bildern und Worten lernt. Nur so wird es möglich, über Texteingaben (Prompts) einen entsprechenden Video-Output zu erhalten.

Unter den gelisteten Kanälen sind neben offiziellen Medien wie NYTimes, Vevo, Disney, arte und ähnliches auch andere Größen wie NASA oder TED, Hersteller wie GoPro ebenso wie bekannte und unbekannte YouTube-Creators.

// Top-News auf einen Blick:

- Blackmagic DaVinci Resolve 20 Beta 2 bringt neue Funktionen und Bugfixes

- Blackmagic Camera for Android 2.1 bringt neue Features

- Neuer superschneller PoX Flash-Speicher könnte DRAM und SSDs ersetzen

- Achtung: Verpixelte Videos können wieder kenntlich gemacht werden

- KI-generierte Fake-Trailer: Wie Hollywood an der Irreführung der Zuschauer ...

- Beleuchtung für Foto und Video lernen mit kostenlosem Tool von Google

Nun ist natürlich nicht direkt nachzuweisen, dass jedes aufgeführte Video tatsächlich für das Training genutzt wurde. Jedoch gelang es den Journalisten von 404, für ihren Artikel stichprobenweise mit Runway Gen-3 Clips im Stile einiger gelisteter YouTuber zu generieren, was darauf schließen läßt, dass deren Videos im aktuellen Korpus enthalten sind. Spezifisch wurden dabei auch deren Namen eingegeben - seitdem wurde diese Möglichkeit wie es scheint von Runway unterbunden, jedoch gab es laut 404 keine direkte Stellungnahme zu dem Vorwurf.

Dass YouTube-Clips zum Training von Video-KIs verwendet werden, wird wie eingangs erwähnt ja seit langem vermutet - einen solch konkreten Nachweis wie in diesem Fall hat es unseres Wissens noch nicht gegeben. Wir sind gespannt auf das (rechtliche) Nachspiel - mehrere Klagen laufen bereits gegen Betreiber von generativen KI-Modellen wegen der unrechtmäßigen Verwendung von Text-, Bild- und Musikmaterial.

Als Runway Gen-1 im Februar 2023 erstmals gezeigt wurde, lautete das Motto übrigens "No lights. No camera. All action." Dass es letztlich natürlich doch nicht ganz ohne Licht und Kamera geht, illustriert dieser Leak nun recht eindringlich.