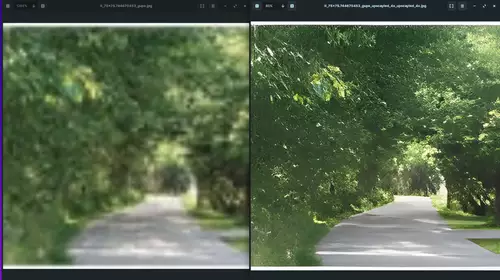

Eigentlich klingt die Idee, alte Filme und TV-Serien, die nur in niedriger Auflösung vorliegen, per KI auf HD oder gar 4K hochzuskalieren, ganz gut: Idealerweise sind sie dann auch auf großen Fernsehern scharf und man sieht ihnen ihr Alter visuell nicht mehr an. Das dachte sich wohl auch Netflix, als es die US-Comedy-Serie "A Different World" (auf Deutsch "College Fieber" getauft), ein Spin-off der "Cosby Show" aus den Jahren 1987 bis 1993 im Februar 2025 in sein Programm nahm und dafür per KI von der ursprünglichen 360p- oder 480p-Auflösung auf 4K hochskalierte und vom 4:3-Format nach 16:9 beschnitt.

Leider aber demonstriert die bearbeitete Version von "A Different World" die Probleme von KI-basiertem Upscaling, denn im resultierenden 4K-Stream sind oftmals ins Groteske verzerrte Gesichter, unlesbare Zeichen statt Buchstaben sowie andere Bildfehler zu sehen. Der TikToker Scott Hanselmann (https://www.tiktok.com/@shanselman/video/7476722348779998506) hatte diese Probleme als erster in mehreren Videos demonstriert und damit eine heftige Diskussion ausgelöst.

Die Fehler fallen aus der Entfernung nicht immer auf, aber aus der Nähe, auf einem großen Display oder wenn man den Stream pausiert zeigen sich groteske Bildphänomene. Um die Ursache dieser typischen Hochskalierungsfehler zu erkennen, muss man jedoch verstehen, wie diese Methode überhaupt arbeitet.

Wie funktioniert Hochskalieren der Auflösung per KI?

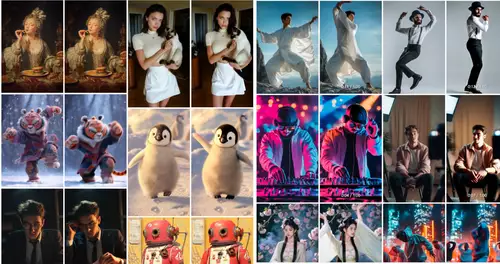

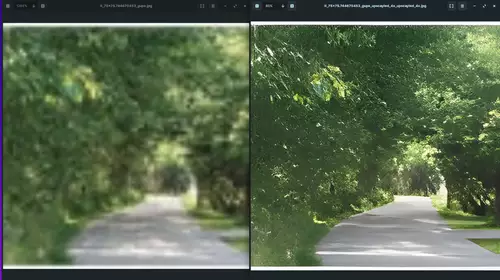

War man früher davon ausgegangen, dass bei einer Vergrößerung der Auflösung eines Bildes keine Details hinzukommen können, welche nicht im Ausgangsbild enthalten sind (weil die Informationen dafür schlicht fehlen), findet seit einigen Jahren dank Super-Resolution-Technologie bzw. KI ein Paradigmenwechsel statt, denn damit können jetzt einem Bild mehr Details hinzugefügt werden, als ursprünglich in digitaler Form vorlagen. Doch wie ist das möglich? Super Resolution Verfahren nutzen für das "Mehr an Pixeln" und damit mehr an Bildinformationen nicht die alte und eher primitive Interpolation zwischen bekannten Pixeln, sondern erfinden Details schlüssig hinzu.

Möglich ist das durch die Deep-Learning-Technologie, da solche KI-Algorithmen dank Training mit Millionen von Bildern sehr gut darin sind, alle möglichen Arten von Objekten auf einem Bild zu erkennen und sinnvoll zu ergänzen. Beim Hochskalieren machen sich neuronale Netze die typischen Muster natürlicher Objekte zunutze – d. h. Strukturen in den Bildern mit niedriger Auflösung werden beim Hochskalieren (meist) sinnvoll rekonstruiert.

Wenn also eine entsprechende Super Resolution KI beispielsweise Millionen von Gesichtern aus verschiedenen Blickwinkeln und in diversen Beleuchtungssituationen gesehen hat, kann sie anschließend jedem grob nur aufgelösten Gesicht in einem Bild gelernte passende Details hinzufügen. Das gilt genauso für Pflanzen, Autos, Tiere oder beliebige andere Objekte. Man sollte allerdings im Hinterkopf behalten, dass die entstehenden hochskalierten Bilder nur sehr wahrscheinliche, zusätzliche Details enthalten und nicht die "wahren" Details aus der ursprünglichen Aufnahmesituation des Bildes.

// Top-News auf einen Blick:

- Blackmagic DaVinci Resolve 20 Beta 2 bringt neue Funktionen und Bugfixes

- Blackmagic Camera for Android 2.1 bringt neue Features

- Neuer superschneller PoX Flash-Speicher könnte DRAM und SSDs ersetzen

- Achtung: Verpixelte Videos können wieder kenntlich gemacht werden

- KI-generierte Fake-Trailer: Wie Hollywood an der Irreführung der Zuschauer ...

- Beleuchtung für Foto und Video lernen mit kostenlosem Tool von Google

Die typischen Hochskalierungs-Bildfehler

Auffällige Bildfehler entstehen, wenn die fürs Hochskalieren zuständige KI nicht "intelligent" genug ist und so zum Beispiel wichtige Objekte wie Gesichter nicht ausreichend gut aus allen Perspektiven erkennt. Nimmt sie als Folge das Wissen von relevanten Merkmalen aus vorhergehenden oder nachfolgenden Frames nicht mit, um es in eine neue Ansicht eines Bildes zu integrieren, kann sie keine ausreichende Objektkonsistenz herstellen.

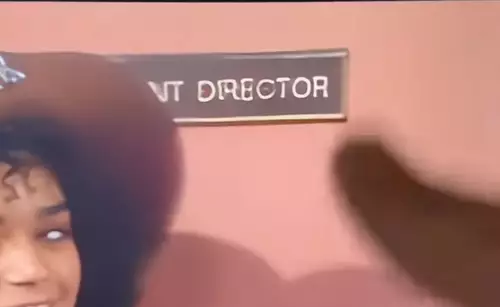

Ein anderes Problem bilden z. B. Schilder oder andere Flächen, auf denen Text zu sehen ist, der aufgrund der schlechten ursprünglichen Auflösung aber nicht einfach zu rekonstruieren ist – die KI erkennt zum Teil, dass es sich um Buchstaben handelt und skaliert diese zu erkennbaren Buchstaben hoch, aber da oft zu wenige Informationen bereitstehen, irrt sie sich manchmal und rekonstruiert aus den wenigen Pixeln unleserliche Zeichen wie im folgenden Beispiel:

Eine moderne multimodale KI, die auch Buchstaben im Zusammenhang als Text versteht und den Kontext eines Textes erkennt, könnte hier dafür sorgen, dass es nicht zu solchen Textfehlern kommt - rekonstruierte Texte könnten dann konsistent und sinnvoll sein, wenn auch nicht "wahr". Ebenso könnte sie Objekte über mehrere Szenen erkennen und Gesichter so immer richtig rekonstruieren. Zumindest mit etwas mehr Sorgfalt hätten durch manuelles Eingreifen so schlechte Ergebnisse vermieden werden können.

Netflix könnte es besser

Es ist nicht ganz klar, ob der aktuelle Rechteinhaber, die Carsey-Werner Company, welche "A Different World" an Netflix lizenziert hat, für das schlechte Upscaling verantwortlich ist oder Netflix selbst. Ein Rätsel ist aber, wie ein derart mangelhaftes KI-Upscaling-Ergebnis von der Netlix-Qualitätskontrolle durchgewunken werden konnte.