Forschern der Stanford Universität ist etwas Erstaunliches gelungen – sie haben mit FramePack eine Video-KI als Open Source veröffentlicht, die es Dank einer neuartigen Architektur erstmals ermöglicht, KI-generierte Videos mit nur 6 GB Grafikkartenspeicher zu erstellen. Bislang waren für die Generierung von hochwertigen Videos per KI meist mindestens 12 GB VRAM nötig – nun reicht selbst eine Nvidia RTX 3050 oder vergleichbare Mittelklassen-GPU aus, um kostenlos auf dem eigenen PC Videos zu erzeugen. Zudem ermöglicht das neue Verfahren theoretisch eine Cliplänge von bis zu einer Minute, also weitaus mehr als aktuelle Video-KI-Modelle, die auf dem eigenen PC laufen und auch mehr als die meisten Online-Video-KIs.

Was macht FramePack anders?

Traditionelle Video-Diffusionsmodelle betrachten für jeden neuen Frame eine wachsende Anzahl zuvor erzeugter, noch verrauschter Bilder. Dieser „temporale Kontext“ skaliert linear mit der Cliplänge und treibt den Speicherbedarf in die Höhe. Diese Methode stößt bei längeren Videos oft auf zwei Probleme: Sie neigen dazu, zu "vergessen", was am Anfang des Videos geschah, und die Bildqualität lässt durch die Anhäufung kleiner Fehler nach, was als "Abdriften" bezeichnet wird.

Congrats on Lvmin Zhang’s (github@lllyasviel) latest project FramePack and thank you for using and recommending HunyuanVideo.FramePack&s Brief Intro and Showcases Attached: FramePack is a… pic.twitter.com/xvKQ5wwwzK

— Hunyuan (@TencentHunyuan) April 17, 2025

FramePack begegnet diesen Herausforderungen, indem es die Videobilder je nach ihrer Wichtigkeit in eine fest definierte Kontextlänge komprimiert, wodurch der GPU-Speicherbedarf drastisch sinkt. Dadurch kann FramePack mehr Bilder verarbeiten, ohne dass die Berechnungen zu komplex werden, was dem "Vergessen" entgegenwirkt. Zusätzlich werden spezielle Techniken wie das "Anti-Drifting-Sampling" angewendet, die beispielsweise den Kontext des gesamten Videos besser erfassen, um das Abdriften zu minimieren und die visuelle Qualität zu steigern. Die für die Generierung von Videos notwendige Rechenpower soll vergleichbar sein mit der für die einzelnen Standbilder im Diffusions-Verfahren. Ein FramePack-Modell mit nur rund 13 Milliarden Parametern schafft es so, einen 60-Sekunden-Clip auf einer GPU mit lediglich 6 GB VRAM zu erzeugen.

Systemvoraussetzungen und Performance

FramePack läuft momentan auf Grafikkarten aus der Nvidia RTX-30/40/50-Serie mit mindestens 6 GB Grafikkartenspeicher, also auch auf den Mobilversionen der passenden GPUs. Eine Nvidia RTX 4090 generiert – optimiert per „teacache“ – rund 0.6 Frames pro Sekunde, wobei jedes Bild unmittelbar nach der Generierung angezeigt wird. Nvidia Turing- und ältere Generationen sind offiziell nicht verifiziert, AMD- oder Intel-GPUs oder Apples M-Chips werden derzeit nicht unterstützt. Man kann FramePack aber auch zum Beispiel per Hugging Face auf gemieteter Hardware nutzen, dann allerdings kostenpflichtig.

// Top-News auf einen Blick:

- Blackmagic DaVinci Resolve 20 Beta 2 bringt neue Funktionen und Bugfixes

- Blackmagic Camera for Android 2.1 bringt neue Features

- Neuer superschneller PoX Flash-Speicher könnte DRAM und SSDs ersetzen

- Achtung: Verpixelte Videos können wieder kenntlich gemacht werden

- KI-generierte Fake-Trailer: Wie Hollywood an der Irreführung der Zuschauer ...

- Beleuchtung für Foto und Video lernen mit kostenlosem Tool von Google

Installation auf dem eigenen PC

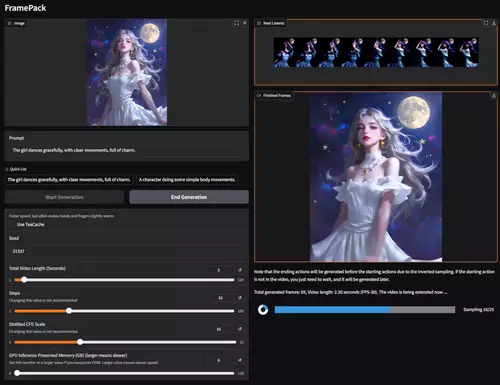

Die einfachste Installationsvariante auf dem lokalen PC bietet wohl der Pinokio Browser. Das gesamte FramePack-Paket ist allerdings satte 48.5 GB groß. FramePack bringt eine eigene Bedienoberfläche mit, in der ein Startbild sowie ein Prompts eingegeben wird. Letzteres beschreibt, welche Veränderungen das Bild dann im Video durchlaufen soll. Zudem kann die gewünschte Cliplänge eingegeben werden – idealerweise wird sie erst klein angesetzt und dann – bei einem guten Ergebnis – allmählich auf die volle Länge gesteigert. Analog erfolgt der Einsatz von teacache, denn damit wird die Generierung beschleunigt, aber manchmal auch fehlerhafter; er eignet sich so aber gut für eine schnelle Vorschau. Es können bis zu 1 Minute lange Videos mit 30 Bildern pro Sekunde erzeugt werden.

Qualität: Was kann FramPack und was nicht?

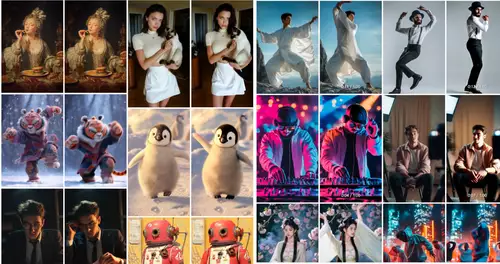

FramePack kann menschliche Bewegungen wie etwa Tanzen sehr gut darstellen (womit manche andere KI-Modelle Probleme haben), was man anhand der Demovideos auf der FramePack-Seite gut sehen kann. Gut ist auch die Objektkonsistenz - es ist kein Morphing zu sehen - auch in längeren Sequenzen. Allerdings scheint FramePack auf die Animation von Objekten eines vorgegebenen Bildes spezialisiert zu sein. Dynamische Kamerabewegungen wie zum Beispiel Tracking Shots, also große Änderungen am Bildhintergund, funktionieren nicht so gut (und sind auch auf den Demos kaum dargestellt). Zudem ist die Auflösung relativ gering - die Democlips sind nur 512 x 768 gross.