Vor etwas über einem Jahr hatte OpenAI die erste Version von DALL-E gestartet, einem neuronalen Netz, welches Bilder nur anhand einfacher Textbeschreibungen generieren kann. Jetzt wurde die neueste Version vorgestellt, welche zahlreiche Verbesserungen aufweist.

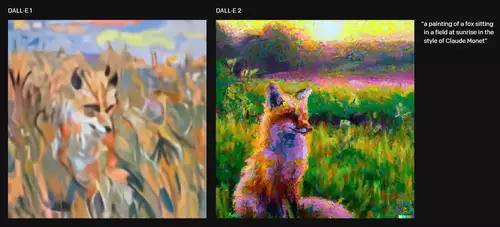

So erzeugt DALL-E 2 nicht nur überzeugendere Bilder, sondern auch mit einer vierfach höheren Auflösung (1.024 x 1.024) als bisher. Und erstmals können Bilder nicht nur generiert, sondern auch gezielt per Text editiert werden - auch können einzelne Bildelemente jetzt sowohl zum Bild hinzugefügt als auch entfernt werden.

Trainiert wurde DALL-E 2 (ein Portemanteau von (Salvador) Dali und WALL-E) anhand von einer Vielzahl von Bildern samt Bildbeschreibungen. Zudem hat das neuronale Netz die Beziehung zwischen Bildern und dem Text, der sie beschreibt, gelernt. Wer sich für die technischen Details interessiert, findet hier die Forschungsarbeit.

Wie funktioniert DALL-E 2? Beispiele

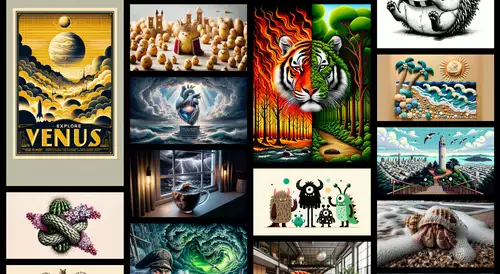

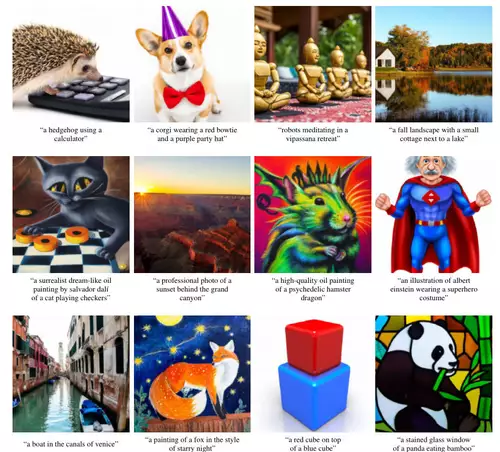

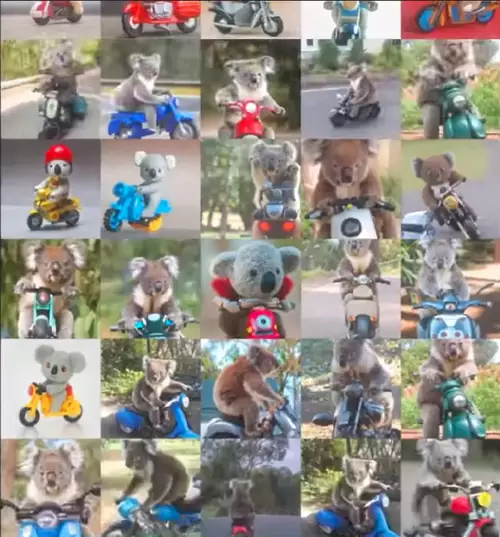

Als Input dient eine Beschreibung, was auf dem zu generierenden Bild zu sehen sein soll - dabei können nicht nur Objekte genannt werden, die im Bild auftauchen sollen, sondern auch Relationen zu anderen Objekten oder auch Handlungen, also etwa "ein Igel, der einen Taschenrechner bedient" oder "Hasendetektiv, der auf einer Parkbank sitzt und eine Zeitung liest in einer viktorianischen Umgebung".

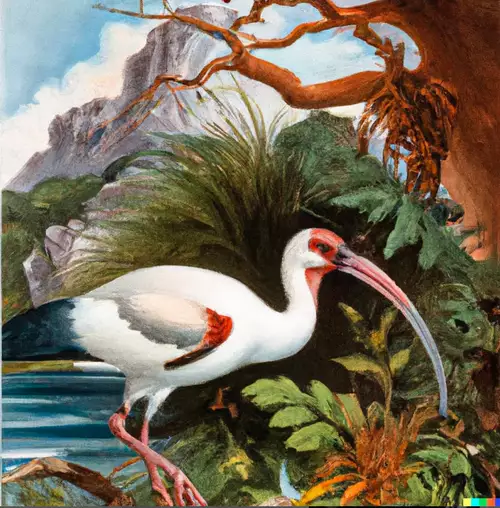

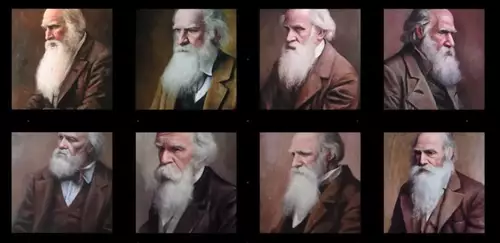

Definiert werden kann auch der Bildstil, denn DALL-E 2 kann ebenso fotorealistische Bilder wie auch Cartoons oder abstrakte Malstile (wie zum Beispiel psychedelisch, Wachsmalstift oder Ölgemälde) oder Stile berühmter Maler (wie Dali, Monet, Picasso und anderen) nachempfinden.

Weitere schöne Beispiele, die DALL-E 2 auf Zuruf von Usern erzeugt hat, finden sich auf Twitter.

Noch gibt es Bildfehler

Wenn man die generierten Bild näher anschaut wird man manchmal einer Reihe von Bildfehlern gewahr, die aus der Entfernung nicht so leicht zu erkennen sind: manche Teilbereiche eines Objekts sind oft etwas eigenartig verzerrt und undeutlich.

Ebenso kann DALL-E 2 keine einzelnen Objekte darstellen, die es nicht kennt, d.h. mit denen es nicht trainiert wurde.

// Top-News auf einen Blick:

- Blackmagic DaVinci Resolve 20 Beta 2 bringt neue Funktionen und Bugfixes

- Blackmagic Camera for Android 2.1 bringt neue Features

- Neuer superschneller PoX Flash-Speicher könnte DRAM und SSDs ersetzen

- Achtung: Verpixelte Videos können wieder kenntlich gemacht werden

- KI-generierte Fake-Trailer: Wie Hollywood an der Irreführung der Zuschauer ...

- Beleuchtung für Foto und Video lernen mit kostenlosem Tool von Google

(Illustratoren-)Jobs in Gefahr?

Die Ergebnisse von DALL-E 2 sind trotzdem erstaunlich - sind der Phantasie doch keine Grenzen gesetzt. Es kann potentiell jedes Bild erzeugt werden, das man sich ausdenken und beschreiben kann - egal wie phantastisch oder absurd das Motiv ist. Befürchtet wird schon - sollte der Algorithmus allgemein zugänglich sein und die Bildqualität noch etwas besser werden - dass Illustratoren ihre Jobs verlieren könnten, da auch ganz spezielle Bildmotive ganz einfach nach freier Beschreibung mit DALL-E 2 in Sekundenschnelle - samt einer Unzahl von Bildalternativen in allen möglichen Stilen zur Auswahl - erzeugt werden können.

Solche neuen Entwicklungen in Sachen KI per neuronaler Netze zeigen, daß Vorhersagen über den Einfluss von künstlicher Intelligenz auf das Arbeitsleben nur sehr schwer zu treffen sind. Vor einem Jahrzehnt noch war die gängige Meinung, dass KI zuerst die körperlichen Arbeiten ersetzen würde, dann die kognitive Arbeit und dann vielleicht, eines Tages, die kreative Arbeit. Jetzt sieht es so aus, als würde die umgekehrte Reihenfolge zutreffen. Sind in einer zukünftigen Version erst einmal alle offensichtlichen Bildfehler ausgemerzt - wie soll dann noch unterschieden werden, ob ein Bild von einem Menschen oder einer KI produziert wurde?

Noch mehr Beispiele finden sich auf Instagram.

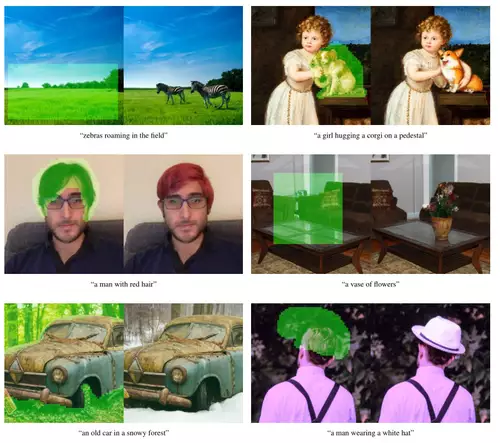

Bilder per DALL-E 2 editieren

Die neue Möglichkeit des nachträglichen Editierens ("Inpainting") von Bildern per DALL-E 2 funktioniert ganz einfach - so wird erst grob ein Bildbereich markiert, an welchem die Änderung vollzogen werden soll und dann per Text beschrieben, was geändert werden soll. So kann zum Beispiel einer Person nachträglich ein Hut aufgesetzt werden oder ein Objekt im Bild hinzugefügt oder entfernt oder auch der Hintergrund ausgetauscht werden.

Das besondere dabei: es werden bei diesen Operationen auch Schatten, Reflexionen und Texturen der Objekte und des Hintergrunds automatisch berücksichtigt, ebenso wird der Stil (egal ob fotorealistisch oder verfremdet) an den des Bilde angepasst.

DALL-E 2 kann bei Eingabe eines Bildes auch Variationen davon generieren:

Die Gefahren durch KI-generierte Bilder

Das OpenAI-Team hat den direkten Zugriff auf die API von DALL-E 2, also die Möglichkeit für (potentiell) jedermann frei Bilder damit zu generieren, eingeschränkt und vorerst nur für eine kleine Gruppe ausgewählter User freigegeben. Die Möglichkeiten des Missbrauchs wird für zu gefährlich angesehen - seien es pornographische Bilder oder Gewaltdarstellungen.

Die Forscher haben sich deswegen auch bemüht, sexuelle und gewalttätige Inhalte aus den Trainingsdaten für DALL-E 2 herauszufiltern. Zudem sollen Filter für Texteingaben und hochgeladene Bilder einen Missbrauch des Systems abwehren. Ebenso wurde der Trainingsprozess geändert, um die Fähigkeit des DALL-E 2-Modells, sich Gesichter aus den Trainingsdaten zu merken, zu begrenzen, um zu verhindern, dass das Modell Bilder von Prominenten und anderen Personen des öffentlichen Lebens originalgetreu wiedergibt.

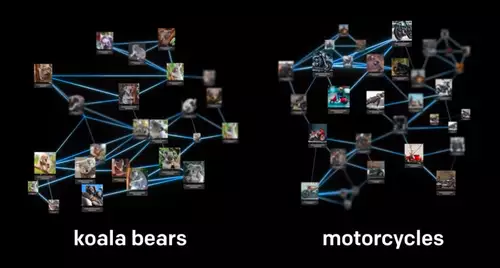

Verstehen wie das neuronale Netz funktioniert

Das Team von OpenAI hofft, daß DALL E 2 auch hilft zu verstehen, wie fortschrittliche KI-Systeme unsere Welt sehen und verstehen. Das ist wichtig, da DeepLearning Systeme eine Art Black Box darstellen, da sie selbstlernend sind und man oft nicht nachvollziehen kann, was genau gelernt wurde. Anhand von DALL-E 2 und den damit generierten Bildern - und auch anhand der misslungenen - gibt es die Möglichkeit, etwas tiefere Einblicke in die innere Funktionsweise des neuronalen Netzes von DALL-E 2 zu gewinnen.

Was bringt die Zukunft?

DALL-E 2 folgt auch einem weiteren wichtigen neuer Trend der Evolution der Schnittstelle zwischen Mensch und Computer: der Mensch sagt was er will - in natürlicher Sprache oder mit kontextuellen Hinweisen - und der Computer erledigt es. Was jetzt bei der Erzeugung und Manipulation von Bildern gilt, wird in Zukunft bei komplexen anderen Aufgaben funktionieren, ganz dem Beispiel von Siri und anderen virtuellen Assistenten folgend - nur noch funktionsmächtiger und weitere Arbeitsfelder umfassend.

Macro 35mm film photography of a large family of mice wearing hats cozy by the fireplace

Die neue Version von DALL E bestätigt uns auch in unserer schon zur ersten Generation getroffenen Vermutung, daß der nächste logische Schritt, die Generierung und auch das Verändern von bewegten Bildern nach Beschreibung, nicht mehr lange dauern wird. Denn das war schon bei vielen anderen KI Algorithmen zur Bildmanipulation der Fall, da Videos als Abfolgen von Einzelbildern nur eine weitere - wenn auch rechenintensivere - Dimension darstellen.