Im zweiten Teil unserer HDR Basics wollen wir einmal die wichtigsten Formate möglichst erhellend darstellen und müssen auch hierfür noch einmal etwas ausholen...

(Wie sich HDR im Foto- und Filmbereich unterscheidet, was Nits sind ua. erklären wir in HDR Basics Teil 1)

Wann spricht man von HDR?

In der Praxis kamen 2017 die meisten Consumer HDR-Displays selten über 10 Blendenstufen hinaus, weshalb man bei Monitoren schon LCD-Geräte mit maximal 300 Nits bereits als HDR-fähig vermarktet hat. Und dagegen ist nicht einmal etwas zu sagen, denn es gibt leider bei der Definition von HDR einen enormen Wildwuchs.

Sinnvoll ist daher zuerst einmal eine Abgrenzung “von unten”: Bei Fernsehern hatte die SMPTE RP166/167 für Rec. 709 maximal 120 Nits empfohlen, bei einem gleichzeitigen Dynamikumfang von sieben Blendenstufen. Dies würde einen definierten Schwarzwert von einem Nit bedeuten. Alles über sieben Blendenstufen könnte man demnach als HDR ansehen. Doch das ist verständlicherweise als Definition nicht befriedigend.

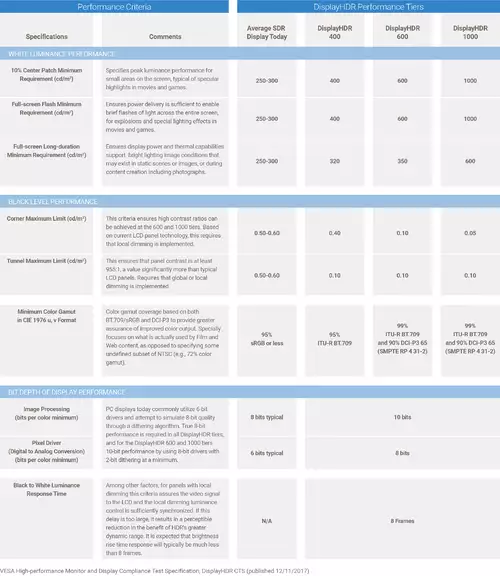

Auch aus diesem Grund hat die Industrievereinigung VESA Ende 2017 den offenen Standard DisplayHDR 1.0 verabschiedet. Dieser teilt die HDR-Fähigkeiten eines (LCD-)Displays in drei Klassen ein.

Die niedrigste Klasse DisplayHDR-400 fordert eine Spitzenhelligkeit von 400 Nits (bei 0,4Nits Schwarzwert), echte 8-Bit (also kein 6+2), globales Dimming sowie einen Farbumfang von mindestens 95% des BT.709-Farbraums.

Der mittlere Standard DisplayHDR-600 definiert eine Spitzenhelligkeit von 600 Nits, 0,1 Nits Schwarzwert sowie 10-Bit Bildverarbeitung (auch 8-Bit mit 2-Bit Dithering).

Erst das Top-Format DisplayHDR-1000 erweitert diese Definition auf eine noch größere Helligkeit von 1.000 Nits bei 0,05 Nits Schwarzwert. Dies darf auch durch ein lokales Dimming erreicht werden. DisplayHDR-600 und 1000 erfordern einen Farbumfang von mindestens 99% des BT.709-Farbraums und 90% des DCI-P3 Farbraums.

Rechnet man diese Angaben in Blendenstufen um, so bietet HDR400 ungefähr 10 Blendenstufen, HDR600 12,5 Blendenstufen und HDR1000 ca. 14,2 Blendenstufen.

Unter 10 Blendenstufen sollte Jahre 2018 daher kein Gerät als HDR durchgehen. Aus eigener Erfahrung würden wir sogar erst ab 12 Blendenstufen aufwärts sinnvollerweise von HDR sprechen. Doch wie es aussieht, bleiben die Grenzen trotz (und auch gerade wegen) der VESA nun fließend.

Ist (analoges) Kino nicht HDR?

Je nach Definition höchstens ein bisschen. Eine typische Filmprojektion hat eine deutlich geringere Helligkeit als HDR-Displays und erreicht im Kino allerhöchstens 100 Nits (meistens sogar eher nur 50 Nits). Im Kino sorgt also vor allem die extrem dunkel gehaltene Umgebung für die wahrgenommene Dynamik, die über den Daumen gepeilt um die 9 Blendenstufen liegt.

Diese ist somit weitaus geringer als eine gute HDR-Wiedergabe. Mittlerweile gibt es jedoch Bestrebungen (u.a. von Dolby) im Kino über hellere Projektionen für mehr Dynamik und damit letztlich auch für HDR zu sorgen.

Wie tief können Schatten gehen?

Betrachtet man die Bereiche in denen sich die HDR-Formate von SDR unterscheiden, so sieht man, dass durch die Erweiterung der Lichter durchschnittlich 3 Blendenstufen hinzugewonnen werden, während die Schatten sich ungefähr um sechs Blendenstufen nach unten erweitern. HDR spielt sich also tatsächlich viel mehr in den Schatten, als in den Lichtern ab. Das macht einerseits Sinn, da man ab einer gewissen Helligkeit schlichtweg geblendet wird, jedoch gibt es nach unten hin andere, nicht minder gewichtige Probleme.

Dabei geht es in erster Linie um die Umgebung des Displays oder der Leinwand. Nur bei absoluter Dunkelheit lassen sich die zusätzlichen sieben Blendenstufen nach unten auch noch vom menschlichen Auge differenzieren. Schon weiß gestrichene Wände im Wohnzimmer reflektieren jedoch die Ausgabe des Displays derart stark, dass die tiefsten Schwarzwerte nicht mehr aufgrund des Streulichts unterschieden werden können. Hat man dann noch eine gedimmte Beleuchtung, reduziert man damit den realen Zusatznutzen von HDR in den Schatten deutlich.

Was ist eine EOTF?

Wie man an dieser Stelle schon ahnen kann, sollte die HDR-Ausgabe aus vielen Gründen möglichst genormt erfolgen. Schließlich ist es im Interesse aller Beteiligten, dass das wahrgenommene Bild in möglichst vielen Umgebungen und auf möglichst vielen Geräten möglichst gleich aussieht. Dies sollte ursprünglich eine EOTF gewährleisten. Unter einer EOTF (Electro-Optical Transfer Function) versteht man eine Übertragungsfunktion, die exakt beschreibt, wie das digitale HDR-Signal in ein sichtbares Bild umzuwandeln ist.

Sie soll die künstlerische Intention des Originalvideos bewahren und im besten Fall das Video so darstellen, wie es im Studio auf dem Mastering-Monitor aussah. Dies kann in den meisten Fällen natürlich nur eine Annäherung sein, jedoch könnte mit einer EOTF jeder Hersteller die Abweichungen seines Displays in gewissen Schranken neutralisieren bzw. umschiffen.

Doch leider ist es ein weiteres Mal im Vorfeld der HDR-Einführung nicht gelungen, hier einen verbindlichen Standard zu etablieren. Stattdessen haben wir mittlerweile mindestens drei gewichtige Vertreter:

HDR10(+), HLG und Dolby Vision

Um es einfach zu halten, sollten wir mit PQ (Perceptual Quantizer) anfangen. Dies ist kein eigenes Format, sondern sowohl HDR10(+) als auch Dolby Vision basieren auf diesem auch als SMPTE ST 2084 bekannten Standardisierungsvorschlag.

PQ manifestiert, dass der Referenz-Weißwert von 100 Prozent immer mit 100 Nits wiedergegeben wird. Glanzlichter oder andere Highlight-Details können weit darüber darüber gespeichert werden. Aber auf HDR-Monitoren mit zu wenig Nits, werden diese Details gnadenlos abgeschnitten, also geclippt. Diese Art der Codierung mit festen Werten bezeichnet man auch als absolut bzw. “display-referred”.

Dolby verwendet PQ in seinem Dolby Vision-Standard mit 12 Bit Farbquantisierung. HDR10 verwendet dagegen “nur” 10 Bit, kostet dafür aber keine Lizenzgebühren. Manchmal spricht man daher auch einfach nur kurz von PQ10 und PQ12 um die beiden Verfahren zu unterscheiden. Um den Anschluss zu Dolby nicht zu verpassen, haben unter anderem Samsung, Panasonic und Amazon HDR10 noch mit einem “Plus”-Standard erweitert, der für jeden Frame eine eigene dynamische EOTF speichern kann. Damit kann HDR10+ theoretisch durch variables Tone-Mapping auch eine zu Dolby vergleichbare Dynamik erzielen.

HLG (Hyper Log Gamma), der Dritte große HDR-Standard wurde dagegen bewusst ohne einen festen Helligkeits-Referenzwert definiert. Man spricht hier oft von relativ oder “scene-referred”. Bei der Ausgabe “soll” der Weißpunkt einfach bei 50 Prozent der Spitzenleuchtdichte liegen. Ein 100 Nits-Display zeigt 100%Weiß somit mit 50 Nits an. Bei einem 500 Nits-Display wird 100%Weiß dagegen mit 250 Nits dargestellt. Der Clue an HLG ist, dass der untere Teil der Kurve der bisherigen REC709, also der SDR-Dynamik entspricht. Die Lichter über 50%-Signalpegel werden jedoch logarithmisch komprimiert.

Dies hat Vorteile mit der Kompatibilität von älteren Geräten. Denn auch SDR-Monitore können somit HLG-Dateien bedingt korrekt darstellen. “Nur” die Lichter werden hier zusammengestaucht, während sie auf HDR-Displays in einen breiteren Dynamikraum entzerrt werden.

Was bedeuten drei Formate das für das HDR-Mastering?

Auch wenn man auf Messen mittlerweile Hard- und Software sieht, die zwischen den gängigsten HDR-Formaten umwandeln kann, raufen sich viele Coloristen bei diesem Thema die Haare. Denn der aktuelle Stand der Erfahrungen ist, dass man für jedes Format noch manuell Hand anlegen muss, um zu guten Ergebnissen zu gelangen. Tatsächlich werden aktuelle Filme -wenn gefordert- in den drei HDR-Versionen separat gegradet. Zusätzlich zu einer SDR-Version für die Massen, die sich ebenfalls nicht einfach automatisiert aus einem HDR-Master erstellen lässt.

Ob sich hier in Zukunft noch bessere Automatismen finden werden, steht in den Sternen, jedoch ist eher zu erwarten, dass einer der oben genannten Standards das Rennen machen wird. Und damit die anderen Standards wieder in der Bedeutungslosigkeit verschwinden werden.

Ist HDR immer mindestens 10 Bits?

Ja! Sowohl HDR10(+) als auch HLG erfordern laut Spezifikation eine Quantsierungstabelle von mindestens 10 Bit. Dolby Vision (er)fordert wie erwähnt sogar 12 Bit. Sony bietet zwar bei einigen Kamera-Modellen auch HLG-Aufnahme-Möglichkeiten mit 8 Bit, jedoch ist dies nicht konform zur HLG-Format-Spezifikation. 8 Bit sind im Rahmen von HDR unter anderem wegen der folgenden Problematik als kritisch anzusehen:

Könnte man nicht einfach das SDR-Bildsignal auf einem HDR-Display “strecken”?

Prinzipiell spricht erst einmal theoretisch wenig dagegen, den Schwarzwert und den Weißwert des SDR-Signals für die Wiedergabe auf den minimalen und maximalen Pegel eines HDR-Displays zu strecken. Da in normalen 8 Bit Formaten jedoch nur 256 Helligkeitsabstufungen gespeichert werden können, werden im Fall einer Streckung auf einen hohen Dynamikbereich Stufen zwischen den einzelnen Helligkeits-Werten deutlich sichtbar. Solche Stufen werden “Banding”, oder “Posterisation” genannt und sie entstehen einfach dadurch, dass die Abstände zwischen zwei Helligkeitswerten auf einem Display mit hohem Kontrastumfang meist deutlich zu unterscheiden sind. Wir haben dieses Problem bereits im ersten Teil unseres Artikels illustriert.

Anders sieht es aus, wenn man ein 10 Bit SDR-Signal auf diese weise streckt. Sollten sich genügend Informationen in den 10 Bit finden, kann dies durchaus ohne weiteres Eingreifen zu zufriedenstellenden Ergebnissen führen. Je nach Geschmack und Material muss man jedoch auch noch oft mit den unterschiedlichen Farbräumen kämpfen.

Kommt HDR oder bleibt es Nischen-Technologie?

Durch das genannte Formatwirrwarr und die sich eher evolutionär entwickelnde Monitor-Technologie lautet unsere Prognose: HDR wird kommen, aber sehr schleichend und in Stufen. Die bezahlbaren Displays werden in den nächsten Jahren nur schrittweise besser, weshalb Dolby auch unserer Meinung nach die schlechtesten Karten hat. Die hohen Hardwareanforderungen von Dolby Vision werden in den nächsten 5 Jahren kaum für eine relevante Masse bezahlbar werden. Im Kino könnte dies vielleicht anders ausgehen (falls dort HDR überhaupt goutiert werden wird), aber im Consumer Umfeld werden erst einmal Monitore zwischen 400 und allerhöchstens 1.000 Nits das Rennen machen. Dafür sind HDR10 und HLG deutlich passender ausgelegt.

Gleichzeitig ist aber der Unterschied von einem HDR-400 oder HDR-600 Display gegenüber einem “normalen” Monitor bei weitem nicht so imposant, dass dies für Otto-Normalverbraucher ein Kaufargument darstellt. Denn hier werden Unterschiede wieder nur im Direktvergleich sichtbar und niemand rennt aus einer HDR-600 Demonstration und sagt danach: “Das brauche ich unbedingt”. HDR-400 und HDR-600 werden in den nächsten Jahren bei Displays einfach selbstverständlich, aber kaum ein Kunde wird für diesen Mehrwert explizit einen Aufpreis bezahlen. Und in ein paar Jahren wird HDR-1000 ebenso selbstverständlich sein. Falls es den den Konsumenten nicht vorher schon zu bunt grell wird.