Boximator ist ein KI-Modell von Bytedance Research - also aus dem geschäftlichen Umfeld von TikTok. Dieses neue Tool dient wie schon viele Vorgänger zur Generierung von realistischen und und zugleich kontrollierbaren Bewegungen in der KI-Videosynthese.

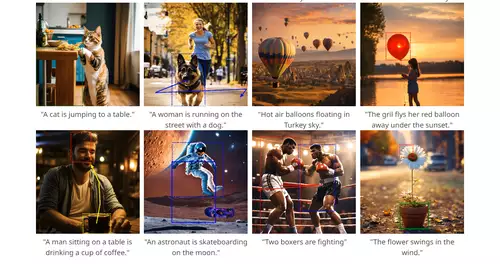

Traditionell wird die KI-Videosynthese durch einen Textprompt ("Text zu Video") gesteuert. Neuerdings lässt sich auch noch ein demonstratives Bild hinzufügen, welches als Ausgangsbild dienen soll. Aus diesem Input generiert ein KI-Modell dann einen bewegten Videoclip. Da man mit Text jedoch nicht immer alles exakt beschreiben kann, bzw. viele Möglichkeiten mehrdeutig bleiben, fällt das Ergebnis oft nicht nach den eigenen Erwartungen aus.

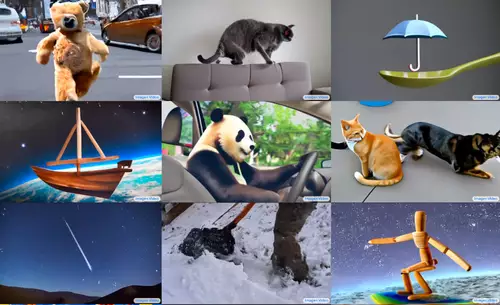

Boximator geht dabei einen neuen Weg der Eingabe: Über Boxen oder Pfadangaben lässt sich dem Modell genauer zeigen, was man sich an Bewegung im Bild wünscht. Dies ist nicht bahnbrechend neu, jedoch wirken die Ergebnisse der erfundenen Bewegungen State of the Art. Beine von laufenden Personen scheinen oft schon sehr gut gelungen (was bei anderen aktuellen KI-Modellen meist noch problematisch ist). Das folgende Video gibt eine gute Übersicht über die Funktionsweise und die Qualität der Ergebnisse:

// Top-News auf einen Blick:

- Blackmagic DaVinci Resolve 20 Beta 2 bringt neue Funktionen und Bugfixes

- Blackmagic Camera for Android 2.1 bringt neue Features

- Neuer superschneller PoX Flash-Speicher könnte DRAM und SSDs ersetzen

- Achtung: Verpixelte Videos können wieder kenntlich gemacht werden

- KI-generierte Fake-Trailer: Wie Hollywood an der Irreführung der Zuschauer ...

- Beleuchtung für Foto und Video lernen mit kostenlosem Tool von Google

In 2-3 Monaten soll eine Demo-Webseite veröffentlicht werden, um Boximator mit eigenen Daten ausprobieren zu können. Wer dies nicht mehr abwarten kann, kann aber auch mit dem Team per Email in Kontakt treten, um das Tool sofort auszuprobieren. Genaueres findet sich (am unteren Ende der verlinkten Github-Projektseite). Das zugrunde liegende KI-Modell PixelDance findet sich übrigens hier.

Ein Arxiv-Paper steht ebenfalls schon bereit, allerdings gibt es noch keinen öffentlichen Code zu dem Projekt.