Eigentlich ist es bizarr. Einfach nur die Roh-Daten des Sensors auf einen Speicherträger zu schreiben ist technisch gesehen ziemlich anspruchslos, solange das genutzte Speichermedium nur schnell genug ist. Im Gegensatz zu RAW ist die H.264- oder die gerade aufkommende H.265-(HEVC)-Aufzeichnung ein wahrhaftes Hexenwerk. Mit unzähligen Tricks und äußerst komplexen Algorithmen können hiermit die Daten des Sensors auf bis zu ein hundertstel der ursprünglichen RAW-Größe zusammengeschrumpft werden. Und das meistens sogar, ohne dass Otto-Normalverbraucher einen Unterschied zum Original bemerkt.

Trotzdem lassen sich die Hersteller diese relativ banale RAW-Aufzeichnung meist fürstlich vergüten, während man eine hochkomplexe H.264/5-Kompression auf fast jedem Gerät, das Bewegtbild aufzeichnen kann, quasi hinterhergeworfen bekommt.

Der Grund dürfte in den Verwertungsmöglichkeiten des Materials liegen: Je unkomprimierter desto interessanter für teure (Post-)Produktionen und Profis.

Doch ab wann fängt eine Kompression an visuelle Probleme zu bereiten? Das hängt wie so oft vom geplanten Einsatzzweck ab. Die Daumenregel: Je mehr man noch in der Nachbearbeitung, also der Postproduktion verändern will, desto geringer sollte das Rohmaterial komprimiert sein.

Warum überhaupt Kompression?

Die meisten modernen Codecs, die man vor allem in Geräten der Consumer-Klasse findet wurden in erster Linie zur Distribution erfunden. Heute gängige Codecs wie H.264 oder bald auch HEVC/H.265 wurden vor allem dafür ausgelegt kleinstmögliche Videoströme zu erzeugen, die mit geringer Datenrate übertragen bzw. gespeichert werden können. Um Filme über Youtube oder auch Broadcast zu übertragen, ist eine starke Kompression dabei unumgänglich. EIn Rechenbeispiel kann dies verdeutlichen:

Bei 4K-UHD-Auflösung von 3840 x 2160 Pixeln benötigt ein einziges, unkomprimiertes Bild in 8 Bit bereits 8,3 Megabyte (3840 x 2160 Pixel mal 3 Farbkanal-Bytes für Rot, Grün und Blau). Selbst bei einer minimalen Framerate von 24 Bildern pro Sekunde ergibt sich schon ein Speicherplatzverbrauch von rund 200 Megabyte pro Sekunde. Eine Minute 4K-Video kommt so unkomprimiert auf ungefähr 12 GB Speicherplatz. Pro Minute! In 8 Bit!

Ein HEVC-4K Datenstrom in einer für die meisten Konsumenten nicht von RAW unterscheidbaren Qualität landet im Streaming meist zwischen 15 und 25 MBit/s, also ca. 2-3 Megabyte pro Sekunde. Eine Verringerung der Datenrate auf ein Hundertstel ist also mit HEVC mittlerweile durchaus “drin”.

RAW und H.264 - Kaum sichtbarer Unterschied?

Doch wenn kaum jemand einen Unterschied sieht, dann kann eine H.264/HEVC-Aufzeichnung doch prinzipiell auch keine schlechte Sache in einer Kamera sein, oder?

Manchmal eben doch. Und zwar aus mehreren Gründen: Erstens braucht eine besonders effektive Kompression eine Menge Rechenleistung. Und zwar immer noch deutlich mehr, als man aktuell in eine 4K-Kamera packen kann. Denn erst wenn der Encoder besonders viele Frames einer Szene besonders gründlich analysieren kann, lassen sich die gefundenen Redundanzen im Bild auch wirkungsvoll zusammenfassen und die Datenrate wirklich fast aufs letzte Bit zusammenstauchen. Hierbei spielen professionelle Encoder meistens viele Optionen durch, die man in einer Kamera bei der Aufzeichnung in Echtzeit so kaum berechnen kann.

Schon aus diesem Grund liegt die Datenrate in günstigen 4K-Kameras meistens eher zwischen 60 -150 MBit/s (in H.264), was jedoch für manche Motive ebenfalls noch nicht ausreichend ist.

So kann man bei genauerer Betrachtung durchaus vielfältige Kompressionsartefakte zu Gesicht bekommen. Dies sind beispielsweise matschige Texturen oder sogar Kompressionsblöcke.

Da moderne Codecs auch Muster erkennen kann es passieren, dass Flächenmuster mit feinen Strukturen sich sprunghaft verwandeln. Auch die auf slashCAM oft zitierte Posterisation im Himmelsabschnitten ist manchmal gar nicht auf die 8 Bit-Quantisierung zurückzuführen, sondern kann genauso ein Problem zu niedriger Datenraten sein.

Welche Methoden nun genau bei einer Kompression zum Einsatz kommen, wollen wir an dieser Stelle nicht näher ausführen und stattdessen nur eine grundsätzliche Klassifizierung darstellen, die für die praktischen Anwender auch deutlich mehr Relevanz haben dürfte.

IntERframe und IntRAframe Kompression

Hierbei ist zunächst die Unterscheidung zwischen Inter- und Intraframe Codecs wichtig. Intraframe-Codecs nutzen für die Kompression nur ein einzelnes Bild. Jedes Bild wird von den anderen Bildern unabhängig komprimiert.

Hierbei kommt es in der Regel zuerst zu einer Farbreduktion von RGB nach YUV, dann wird das Bild in einzelne Pixelblöcke zerlegt, die wiederum durch Verfahren wie Diskrete Cosinus Transformation (DCT) + Quantisierung und Huffmann-Codierung sehr platzsparend gespeichert werden können.

Interframe-Codecs gehen über Intraframe-Kompression noch weit hinaus. Da bei einem Videofilm in der Regel aufeinanderfolgende Bilder eine große Ähnlichkeit besitzen, liegt es nahe auch diese durch Kompression weiter zusammenzufassen.

In dieser Überlegung liegt die Hauptstärke moderner Kompressionsverfahren. Sie zerlegen die Bilder eines Videostroms in drei verschiedene Bildtypen:

I-Frames: Das sind Bilder, die mit einem Intra-Frame Verfahren komprimiert wurden. Diese können auch relativ schnell wieder dekomprimiert werden, da sie nicht von anderen Bildern abhängig sind.

P-Frames: Bilder, die aus vorhergegangenen I-Frames (oder auch P-Frames) berechnet werden. Um diese zu entpacken, muss man vorher auch die zugehörigen I-Frames dekomprimiert haben.

B-Frames: Bilder die sowohl aus vorhergegangenen als auch aus nachfolgenden I- oder P-Frames berechnet werden. Diese Frames brauchen nur noch sehr wenig Speicherplatz im Datenstrom. Um B-Frames jedoch wiederherzustellen müssen vorher alle zugehörigen P- und I-Frames entpackt worden sein.

Die Gesamtlänge einer Folge von I-P-B-Frames wird GOP (Group of Pictures) genannt. Je länger die GOP, desto mehr kann die Redundanz zwischen den Einzelbildern zur Speicherplatz-Ersparnis beitragen. In der Distribution sind daher Interframe-Codecs mit langen GOP-Strukturen die Regel.

Intra: Höhere Datenrate nicht gleich bessere Bildqualität!

Auf der Timeline eines Schnittprogramms sind Interframe-Codecs dagegen ziemlich unpraktisch, weil man nicht jedes Bild im zufälligen Zugriff ansprechen kann. Setzt man beispielsweise den Timelinemarker auf einem B-Frame, so muss der Rechner dieses Bild erst aufwändig aus seinen Nachbarbildern errechnen. Während in der Distribution in der Regel nur ein lineares Abspielen des Video-Streams gefragt ist, scrubbt man beim Editing oft auf der Timeline, oder fährt auch mal einen Clip rückwärts an. All dies gelingt bei komplexen Codecs in 4K nur auf sehr schnellen Systemen wirklich sanft und ruckelfrei.

Zum Schneiden bevorzugen die meisten Cutter daher in der Regel einen Intraframe-Codec. Semiprofessionelle Kameras bieten hierfür oft eine I-Frame-Only bzw. Intra-Aufzeichnung an. Diese hat meistens zwar eine deutlich höhere Datenrate, aber nicht zwingend eine bessere Qualität als eine vergleichbare Interframe-Kompression mit viel niedrigerer Datenrate. Denn bei der Intraframe-Kompression kann schlichtweg nicht die Redundanz zwischen den Bildern zur Kompression genutzt werden, was die Datenrate in die Höhe treibt. Dafür verhält sich ein Intra/I-Frame-Codec deutlich responsiver auf der Timeline.

Transcodiert man vor dem Schnitt einen Interframe-Codec in einen geeigneten möglichst verlustfreien Intraframe-Codec lässt sich bei der Aufnahme mit einem Interframe-Codec gegebenenfalls viel Speicherplatz sparen.

Uncompressed, Lossless und weniger

Die Qualität einer Kompression zeigt sich in der Regel erst in der Nachbearbeitung deutlich. Wenn man Bildbereiche stark in der Farbe oder im Kontrast anhebt, werden bei niedrigen Datenraten sehr schnell Kompressionsartefakte sichtbar. Ab einer Kompressionrate von 3:1 oder weniger sind aktuelle Intraframe-Codecs in der Postproduktion auch von geschulten Augen meistens nicht mehr von unkomprimierten Aufnahmen zu unterscheiden.

Als letzte Stufe vor der absolut unkomprimierten Qualität findet man dann noch die sogenannte lossless Kompression. Hierbei wird das Bild (ähnlich einer Zip-Datei) vor der Speicherung noch so zusammengefasst, dass es weniger Speicher benötigt. Entpackt stimmt es jedoch 1:1 mit den Original-Pixeln überein. Hiermit lassen sich in der Regel noch typische Kompressionsraten zwischen 1:1,3 bis 1:1,5 erreichen.

Welche Kompression für was?

Wir persönlich würden für szenische Projekte mit geplanter Nachbearbeitung ohne weitere Tests bedenkenlos mit RAW-Kompressionen von 1:3 oder sogar 1:4 arbeiten. Lossless oder Uncompressed RAW bringt in unseren Augen hier keinen echten Mehrwert und selbst wenn die Speicherpreise für die Produktion keine Rolle spielen, so bedeutet unkomprimiert oder lossless in der Regel noch den doppelten bis dreifachen Aufwand bei der Clip-Verwaltung.

Auch wenn es nicht direkt vergleichbar ist, liegen die Datenraten von den “besten” ProRES-Profilen (ProRes 422 HQ, ProRes 4444 (ohne Alpha)) auch ungefähr in den Regionen einer 1:3 bis 1:4 Kompression. Dies gilt ebenfalls für die Konkurrenz wie Cineform oder DNxHR. Solche 10 Bit-Interframe-Codecs mit vergleichbar hohen Datenraten sind in unseren Augen ebenfalls für Produktionen grundsätzlich bedenkenlos einsetzbar. In der Theorie kann man zwar manchmal noch in RAW-Formaten etwas mehr extreme Dynamikbereiche sichtbar machen als in einer 10 Bit-ProRES Datei, jedoch sind dies in der Regel Bereiche die man für eine szenische Korrektur in diesen Extremen sowieso nur in sehr speziellen Ausnahmefällen nutzen würde.

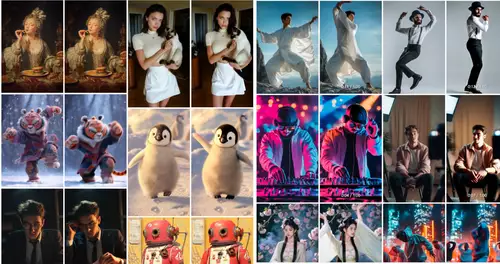

Wer sich ein Bild von den Qualitätsunterschieden machen will, kann dies hier mit einem Online-Vergleich aus einem früheren 10 Bit Codec-Test von uns machen:

In der 600 Prozent Vergrößerung sieht man vor allem, dass sich die nahezu verlustfreien Codecs mit hoher Datenrate (ProRES, DNxHR und CineForm) nur marginal unterscheiden. Sonys XAVC Intra dampft dagegen sichtbar eine Menge Rauschen ein, kann dafür jedoch auch mit deutlich deutlich geringere Datenraten aufwarten.

Jede Kompression unter 4:1 sollte in unseren Augen daher einen (ökonmischen) Grund haben. Sei es im Event-Bereich oder in bestimmten Situationen, bei denen -warum auch immer- nicht genügend Speicherplatz zur Verfügung steht. Außerdem wird ab einer bestimmten Clipmenge tatsächlich auch das Datenhandling zu einer eigenen Herausforderung. Besonders in solchen Fällen kann eine Interframe-Aufzeichnung dann ein wahrer Segen sein, der über so manchen Qualitätsmängel leicht(er) hinwegsehen lässt.