Allerdings ist der Einstieg nicht trivial. Denn neben den zahlreichen Optionen gibt es grundsätzlich im Vorfeld ein paar Dinge zu bedenken, bevor man in eigene Hardware investiert...

Generativ oder transformativ

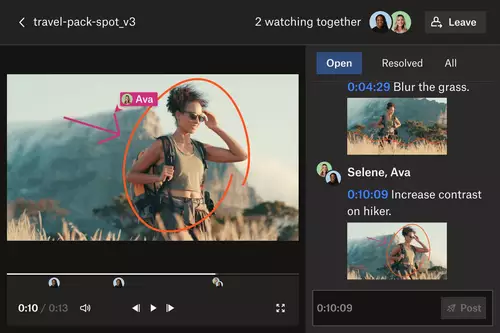

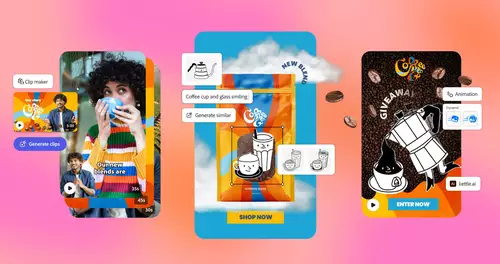

Grob umrissen gibt es im Video-Umfeld aktuell zwei Anwendungsbereiche, in denen KI auf dem Vormarsch ist. Einmal in der generativen Video-KI, die komplette Videoclips aus einem Textprompt, einem Bild und/oder aus beidem erzeugt. Und einmal die transformative Video-KI, welche bestehende Clips verändert, also beispielsweise typische Effekt- oder Compositing-Aufgaben übernimmt.

Die transformative Video-KI wird mittelfristig als Sammlung integrierter Effekte in den Schnitt- und Compositing-Programmen landen bzw. ist dort auch schon teilweise vorzufinden. Alternativ findet sich im Netz auch nichtkommerzieller KI-Forschungs-Code (z.b. auf GitHub), den man für viele State-Of-The-Art Techniken mit eigenem Material selbst ausprobieren kann.

Lokal oder Cloud

Transformative Effekte in einem Schnittprogramm werden in der Regel lokal auf der GPU oder einer NPU ausgeführt. Generative KI braucht dagegen meistens weitaus mehr KI-Ressourcen und findet daher eher in der Cloud statt. Doch die Grenzen, wo die Modelle letztlich ausgeführt werden, sind im Fluss. So wird es immer üblicher, dass auch Schnittprogramme Teile eines Clips zur Verarbeitung in die Cloud schicken und umgekehrt generative KI-Videomodelle auf Consumer Grafikkarten genutzt werden können - sofern man genügend Zeit mitbringt und die passenden Hardware Voraussetzungen erfüllen kann.

Kommerziell oder Open Source

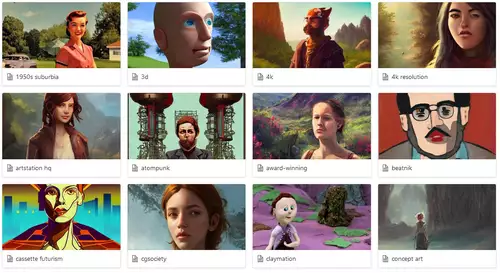

Tatsächlich spielt auch die zugrundeliegende Lizenz eine größere Rolle für den geplanten Einsatz. Wer generative KI am Heimrechner betreiben will, findet fast nur Open Source Modelle zur Nutzung vor. Was meistens zugleich den Vorteil hat, dass diese Modelle bei der "Prompt-Zensur" deutlich lascher vorgehen. Hier liegt in den Händen des Anwenders deutlich mehr Verantwortung, nichts potentiell Unrechtmäßiges zu generieren. Kommerzielle Modelle dagegen schränken viele Ausgaben schnell und stark ein, wenn sie einen Urheberrechts- oder anderweitigen Verstoß vermuten. In der Cloud lassen sich beide Lizenzmodelle finden und nutzen.

Genug ist nie genug...

Abgesehen von diesen relativ klaren Grenzen für die Anwendungsszenarien gilt die folgende Daumenregel bei fast jedem KI-Modell: Je perfekter die Ergebnisse, desto mehr Hardware-Ressourcen benötigt man für den Einsatz.

Lokale KI-Effekte in Premiere oder Resolve sind dabei in der Regel so ausgelegt, dass schon eine einzige schnelle GPU mit genügend Speicher deren Ausführung ermöglicht. Auf günstigen Karten muss man mit deutlich bremsenden Wartezeiten "rechnen".

Die Qualität der lokalen Modelle (besonders bei generativer KI) liegt meistens deutlich unter guten, kommerziellen Cloud-Angeboten. Was schlichtweg daran liegt, dass die Cloud-Services in der Regel deutlich potentere GPUs mit besonders schnellem und großem Speicher nutzen können. Während im bezahlbaren Heimbereich bis 3.000 Euro die maximale GPU-Speichergröße aktuell bei 32-48 GB liegt, besitzen typische Cloud-GPUS nicht nur deutlich mehr Speicher, sondern lassen sich auch noch parallel nutzen. Solche GPUs kosten zwar in der Anschaffung schnell 30.000 Euro und mehr, lassen sich aber für wenige Dollar/Stunde mieten.

Was uns zu einem wichtigen Punkt führt: Lokale KI-Hardware lohnt sich nur, wenn man sie fast durchgehend nutzt. Das ist vor allem beim KI-Training sinnvoll, wo Rechner gerne wochenlang 24/7 durchlaufen, aber nicht bei der Inference, wo immer der Mensch mit einer individuellen Anfrage eine relativ kurze Rechenphase einläutet. Hat der Rechner lange Zeit nichts zu tun, so ist die ungenutzte Hardware nur zur Abschreibung gut. Und absetzen kann man genutzte Cloudservices natürlich ebenfalls.

Darum werden die wenigsten Anwender ein eigenes generatives KI-Modell aufsetzen, trainieren und pflegen, sondern das jeweils beste Modell auftragsweise mieten. Selbst wenn ein Videoclip dann 1 Dollar pro Stück kosten sollte, müsste man 3.000 Clips erstellen, um die Kosten für eine kleine KI-Box wieder drin zu haben. Bei typischer Nutzung von 2 Jahren wären das immer noch mehr als 100 Clips pro Monat.

Mit dem gewaltigen Unterschied, dass Clips in der Cloud wahrscheinlich 100x schneller erstellt werden und eine deutlich bessere Qualität aufweisen - weil sie eben auf deutlich größeren KI-Clustern berechnet werden, die 100x so viel Speicher und Rechenleistung haben. Und nicht zuletzt spart man so nicht unerheblich Strom und Platz.

Trotzdem lokal?

Wer dennoch aus den teilweise oben genannten Gründen lieber lokale KI-Modelle selbst betreiben will, kann sich bei der Auswahl seiner Hardware tatsächlich an zwei Werten orientieren: Verfügbare Speichergröße und Speichergeschwindigkeit. Denn tatsächlich ist fast jedes KI-Modell aktuell durch seinen Speicherdurchsatz limitiert. Das bedeutet, dass die Rechenwerke in der Regel immer auf den Speicher warten müssen.

Dies ist auch der Grund, warum PCs mit sehr viel Speicher in großen KI-Modellen teilweise eine RTX 5090 von Nvidia deutlich hinter sich lassen. Denn ist das Modell größer als der nutzbare Speicher, so muss dieser ausgelagert, bzw. immer wieder langsam nachgeladen werden.

Passt das Modell dagegen komplett in den Speicher, so bestimmt dieser auch die Geschwindigkeit der Anwendung. Ein Beispiel: Nutzt man ein Sprachmodell mit 100 GB Gewichten, so muss dieser Speicher in der Regel einmal komplett gelesen werden, um einen Token als Ausgabe zu erzeugen. Hat der Speicher einen Speicherdurchsatz von 400 GB/s, so wird die Ausgabe ungefähr mit 4 Token/s erfolgen. Ist das Modell nur 50 GB groß, so sollten ca. 8 Token/Sekunde möglich sein. Auf einer GPU mit nur 32 GB Speicher werden solche Modelle dagegen deutlich langsamer sein, weil die GPU hier die Daten nur mit 32 oder 64 GB/s über den PCIe-Bus aus dem meist ebenso langsamen Hauptspeicher lesen kann.

Tatsächlich bietet deswegen gerade Apple relativ interessante Hardware für große lokale KI-Modelle an: So können die neuesten M-Ultra-Prozessoren bis zu 512 GB Speicher mit 800 GB/s nutzen (ab ca. 12.000 Euro). Die schnellste vergleichbare PC-Technologie ist die noch sehr frische AMDs Strix Halo Plattform, welche 128 GB RAM mit ca. 270 GB/s ansprechen kann (ab ca. 2000 Euro). Zum Vergleich: Eine Nvidia RTX Pro 6000 Blackwell GPU mit 96 GB RAM und 1,8 TB/s Speichertranssferrate wird gerade mit ca. 12.000 Euro taxiert. Und auch hier gilt: Wenn das KI-Modell in 96 GB GPU-Speicher passt, ist die Nvidia Karte rasend schnell. Wenn nicht, dann wirds grottig lahm.

Was kaufen?

Auch wenn sich eine RTX Pro 6000 Blackwell GPU sicherlich unter Resolve ganz gut schlägt, lohnt sich eine solche Investition wirklich nur für den seltenen Fall, dass man ein spezielles KI-Modell nutzen will, das den GPU-Speicher effizient ausnutzen kann. Nicht nur für generative KI gilt, dass die lokalen KI-Modelle immer besser werden - die besten Ergebnisse wird man jedoch weiterhin in der Cloud bekommen. Solange man nicht rund um die Uhr seine eigene Hardware auslasten kann, wird sich eine Investition in besonders KI-fähige Hardware nur schwer bezahlt machen und zugleich nur suboptimale Ergebnisse bringen.

Im Bereich der transformativen KI-Effekte in Premiere oder Resolve werden die Hersteller dagegen immer darauf schauen, dass eine breite Anwenderbasis die Effekte auch nutzen kann. Hier werden günstigere GPUs von der Nutzung nicht ausgeschlossen, sondern nur langsamer rechnen. Wir persönlich tippen jedoch stark darauf, dass Adobe, Blackmagic u.ä. bald auch viele KI-Effekte über die Cloud nutzbar machen werden. Und die Preise für die Nutzung werden so kalkuliert sein, dass sich eigene Hardware im Vergleich dazu kaum lohnen wird.

Fazit

Sofern man in Zukunft für generative KI gewappnet sein will, kann man sich entspannt zurücklehnen und muss nicht investieren. Denn die besten Angebote wird man bis auf weiteres in der Cloud zum Mieten finden. Solche KI-Service-Angebote lassen sich meist ohne großes finanzielles Risiko ausprobieren. bzw. schnell kündigen, wenn an der nächsten Ecke ein besseres KI-Modell auftauchen sollte. Wer also schon heute investieren will, sollte dies vor allem mit seiner Zeit tun und die zahlreichen Cloud Angebote erforschen, um am Ball der KI-Möglichkeiten zu bleiben.