Mit der Ankündigung der ersten erschwinglichen 4K-Kameras wird auch die Frage des Chroma-Subsamplings wieder einmal neu aufgekocht. Dabei scheint klar: RAW, 4:4:4 und 4:2:2 sind professionell, 4:2:0 bleibt für die Amateure. Doch wenn man genau hinsieht, liegt bei 4K die Sache etwas anders...

Zu FullHD-Zeiten bekamen Kameras von ihren Bildwandlern meist mehr Pixel-Informationen geliefert, als das finale Videobild an Auflösung zur Verfügung hatte. Entweder besaßen die Kameras (wie bei Panasonics Semi/Pro Liga) gleich drei über ein Prisma getrennte Sensoren mit der nativen HD-Auflösung. Oder es gab eben nur einen CMOS-Bildwandler, der über ein Bayer-Pattern die Luma- und Chroma-Werte für das Debayering zur Verfügung stellte.

Ein nahezu perfektes Beispiel für diese Art der Bildberechnung stellt die Canon C100/300 dar: So hat der Sensor genau die doppelte Anzahl an Horizontal- und Vertikal-Pixeln der FullHD-Auflösung. Dadurch kann jedes RGB-Pixel im Videobild aus exakt vier Bayer-Pixeln zusammengesetzt werden. Also einem R(ot)-, einem B(lau)- und zwei G(rün)-Pixeln.

Bei allen aktuellen 4K-Kameras sieht die Sensor-Situation jedoch überraschenderweise kaum anders aus: So stehen als Grundlage gerade NICHT für jedes fertige 4K-Video-Pixel 4 Bayer-Pixel-Verfügung. Hierfür müsste der Sensor eine Horizontal-Auflösung von 8.000 Bayer-Pixeln bieten. Das schaffen momentan nicht einmal Vollformat-DSLRs.

Stattdessen steht bei 4K vielmehr für die Berechnung eines Pixels nur entweder dessen Rot-, Grün ODER Blau-Wert fest, die fehlenden Werte müssen aus den Nachbarpixeln interpoliert werden. Oder anders betrachtet: Es lässt sich die Luminanz jedes einzelnen Pixels relativ gut durch sich allein bestimmen, die Chrominanz jedoch nur durch mindestens 2 zusätzliche Nachbar-Pixel abschätzen d.h. interpolieren.

Sieht man sich in diesem Wikipedia-Eintrag zum Chroma-Subsampling einmal die Abtastpositionen an, so wird deutlich, dass bei einem 4K-Bayer Sensor für die RGB-Interpretation eigentlich auch nicht mehr Farbinformationen zur Verfügung stehen, als bei einer Y´CbCr 4:2:0-Farbunterabtastung. Jeweils 4 Pixel müssen sich hier die Farbinformation teilen, also ähnlich einem Bayer-Sensor mit RGGB-Filtern, bei dem die RGB-Farbinformation auch erst durch 4 Sensor-Pixel zustandekommen kann.

Nun kann man diese Sicht der Dinge durch entsprechende Interpolations-Interpretationen beim Debayering sicherlich noch etwas in die eine oder andere Richtung drücken, aber Fakt ist, dass man aus einem 4K Sensor mit 4K Bayer-Pattern niemals die Information einer 4K-4:4:4-Farbabtastung bekommen kann, weil einfach zu wenig gesamplete Farbinformationen pro Pixel zur Verfügung stehen. Und selbst eine 4:2:2-Speicherung besteht in den aktuellen 4K-Kameras (im Vergleich zu einer eigentlich nativen 4:2:0 Speicherung) größtenteils aus interpolierten Werten, die man auch in der Postproduktion errechnen könnte.

So gesehen, dürfte eine saubere, uninterpolierte 4:2:0 Speicherung bei einem Sensor mit 4K-Bayer-Auflösung kaum messbare Verluste gegenüber RAW, 4:4:4 oder 4:2:2 aufweisen. Was natürlich nicht den Verlust an Dynamik durch 8 Bit oder sonstige Kompressionsartefakte berührt.

Im Gegenzug bedeutet dies allerdings auch, dass man durch sorgfältiges Downsampling aus einem 8 Bit 4:2:0 4K Signal ein 10 Bit 4:4:4 FullHD/2K-Signal errechnen kann. Also noch weitaus mehr, als Canon gerade mit der C300 aus einem ähnlichen Sensor herausgibt (8 Bit 4:2:2). Diese Diskussion stößt gerade auch Andrew Reid von EOS HD an.

Wir finden jedoch bemerkenswerter, dass 4K-RAW eigentlich kaum mehr Bildinformationen bereithält, als eine 4:2:0 Aufzeichnung mit selber Auflösung. Nur eben mit 14 Bit Dynamik und ohne sonstige Kompression...

[UPADTE]

Nachdem der Nebensatz zum Herunterskalieren von 4K 4:2:0 8 Bit nach 2K 4:4:4 10 Bit im Forum eine Menge Diskussionen verursacht hat, auf wollten wir einfach mal ganz pragmatisch testen, ob die Theorie stimmen kann (wovon wir bisher immer gutgläubig ausgegangen sind). Daher haben wir folgenden Kurz-Test ausprobiert:

1. Wir erstellen in Photoshop einen 8 Bit Verlauf diagonal von weiß nach schwarz, der logischerweise 256 verschiedene Grauwerte enthält.

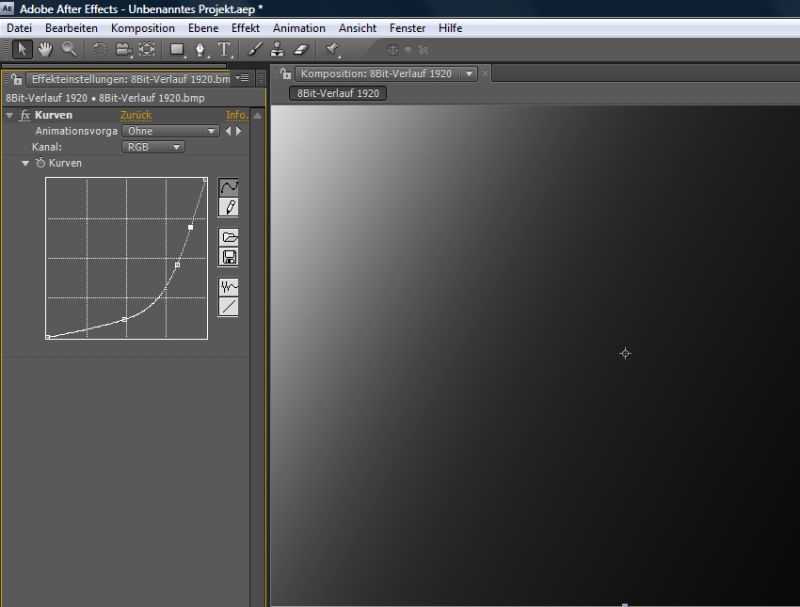

2. Dieses 8 Bit BMP importieren wir in After Effects. Damit kann man gegenüber einer synthetischen Erzeugung in After Effects sichergehen, dass das Input-File garantiert maximal 8 Bit hat.

3. Dann skalieren wir das Bild auf genau 50 Prozent, wodurch After Effects für jedes Output Pixel nun 4 Input Pixel verwendet. Es berechnet also seine Helligkeits- und Farbinformation aus 4 x 8 Bit Pixeln.

4. Zuerst bleiben wir in den After Effects Projekt-Einstellungen bei 8 Bit, d.h. das so berechnete Bild ist auch in der Ausgabe 8 Bit. Anschließend wenden wir eine starke Gradationskurve auf das Material an und es passiert genau das, was man in diesem Fall erwarten würde: Deutlich sichtbares Banding:

Input: 8 Bit -> 50 Prozent skaliert -> Output: 8 Bit

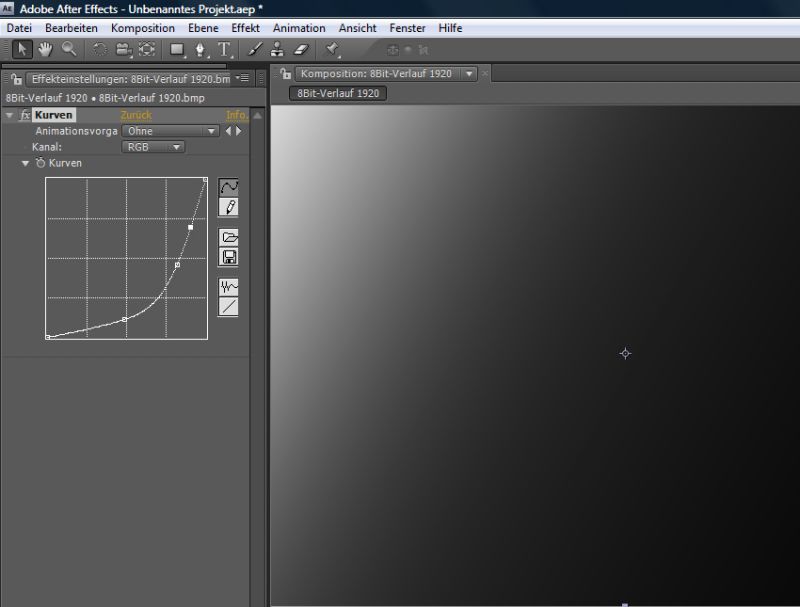

5. Wenn man nun in After Effects auf 16 oder 32 Bit Verarbeitung schaltet, dann kann After Effects im dritten Schritt bei der Skalierung auch Pixel mit mehr als 8 Bit Farbtiefe erzeugen. Das Banding sollte hierdurch deutlich geringer werden, weil nun aus den 4 x 8 Bit Ursprungspixeln mit je 256 Graustufen im Mix theoretisch deutlich mehr verschiedene Graustufen errechnet werden können. Aus (256, 256, 256, 255) kann im 16/32 Bit Modus jetzt auch 255,75 errechnet (und gespeichert )werden. Und eben nicht nur 256, wie in 8 Bit.

Und tatsächlich wird das Banding schon im 16 Bit-Modus deutlich reduziert, bzw in der 100 Prozent-Ansicht vollständig elimiert:

Input8 Bit -> 50 Prozent skaliert -> Output: 16 Bit

Und das obwohl das Ausgangsmaterial garantiert nur 8 Bit ist. Durch diesen pragmatischen Test steht für uns fest, dass auch die Farbtiefe bei einer Pixelzusammenlegung steigt, sofern man höhere Farbtiefen in der Bearbeitung zulässt...

Die 8 Bit auf 10 Bit Skalierung ist also sehr wahrscheinlich keine Mär, zumal wir auch nicht David Newman von Cineform für einen kompletten Idioten halten, der so etwas einfach unhinterfragt aus dem Bauch heraus behaupten würde. Vielmehr steht für uns persönlich nach wie vor fest, dass man durch eine saubere Herunterskalierung von 4K 8 Bit 4:2:0 auf 2K tatsächlich in 10 Bit 4:4:4 Regionen landen kann. Aber darum ging es in diesem Artikel ja eigentlich nur am Rande...