Newsmeldung von slashCAM:Erfahrungsberichte: Erfahrungsberichte: Canon Magic Lantern RAW - Unsere erste Einschätzung von rudi - 22 May 2013 19:56:00

>Mal wieder in Zusammenarbeit mit EOSHD hatten wir heute die Möglichkeit uns einmal näher mit der aktuellen Magic Lantern Firmware an der Canon EOS 5D Mk3 zu befassen und dabei die ersten praktischen Eindrücke zu sammeln...

zum ganzen Artikel

Antwort von Valentino:

Die Idee mit dem Mini-Laptopist ist ganz gut, sollte in der Parxis aber nicht über 60MB/sekunde wegschreiben können.

Gerade wenn an dem USB3.0 Controller noch die Backup HDD hängt,

geht die Kopierleistung schnell in die Knie.

Wer schnell kopieren will, sollte schon ein Notebook der gehobenen Preisklasse wählen.

Wir arbeiten hier mit dem Thinkpad W520, das Platz für zwei 2,5" HDD/SDDs hat und dazu noch über eSata und Express34 verfügt.

Bis jetzt erreichen wir mit UMDA7 Karten über einen Express34 Kartenleser über 70 bis 90MB/Sekunde.

Damit hat der eine oder andere USB3.0 Kartenleser so seine Probleme.

Mit zwei zusätzlichen Akkus kommen wir fast über einen 10h Drehtag.

Antwort von handiro:

Schöne Wortwahl, A1ex and his Magic :-) Das Team leistet wirklich bemerkenswertes, wer hätte das gedacht? Habt Ihr nicht Lust das gleiche mal mit meiner MK2 zu testen?

Antwort von Tiefflieger:

Ich habe mal den Film analysiert.

Die Bilddetails (Schärfe) sind für eine DSLR gut.

Aber der Kontrastumfang ist trotz RAW bescheiden und keine Zeichnung oder Details in Schatten.

Im Zeitindex 3:01 links oben in den Baumschatten gibt es Schwarz-Rauschen.

So wäre die Kamera nichts für mich.

Gruss Tiefflieger

Antwort von Clemens Schiesko:

Aber der Kontrastumfang ist trotz RAW bescheiden und keine Zeichnung oder Details in Schatten.

Im Zeitindex 3:01 links oben in den Baumschatten gibt es Schwarz-Rauschen.

So wäre die Kamera nichts für mich.

Da kann ich dir gerade nicht ganz folgen. Also du schlussfolgerst anhand dieses Video auf den Kontrastumfang vom Canon RAW? Wer weiß denn schon, welche Einstellungen Andrew Reid dort genau vorgenommen, was er inwiefern korrigiert und gegradet hat. Ich habe hier jedenfalls unangepasstes DNG rumliegen, wo sehr wohl noch Zeichnungen und Details in den Tiefen vorhanden sind. Also davon würde ich das nicht abhängig machen.

---------

Ich jedenfalls bin sehr froh über dieses "Update". Morgen sollte meine Lexar 1000x ankommen und wenn das Wetter wieder mitspielt werde ich mich mal an ihr austesten.

Einen positiven Nebeneffekt finde ich zudem, dass ich so einen Klaps auf den Hintern bekomme, mich wieder etwas intensiver mit dem Videomodus auseinanderzusetzen und einen Clip zu basteln. Dieser mag dann zwar vielleicht nichts weltbewegendes sein, aber Impressionen können immer auch Inspiration für andere und eine schöne Erinnerung für einen selbst sein.

Hinzu kommt, dass man durch den RAW-Modus und der geringeren Aufnahmekapazität wohl noch ein wenig bedachter filmt, vielleicht etwas länger überlegt, bevor man auf den Auslöser drückt. Das kann dem Endprodukt nur zugute kommen und neue Erkenntnisse bringen.

Schön finde ich auch, dass nun wieder viele kleine Videos auf Vimeo rumschwirren, die aufgrund des fehlenden Audiokanals viele kleine musikalische Schmuckstücke hervorbringen und man auf Filmproduzenten stößt, deren Videos man vorher vllt. nicht kannte. Ähnlich wie zu den Anfangszeiten der Mark II. Wie gesagt, nur ein positiver Nebeneffekt der mit Magic Lantern jetzt aber nicht viel zu tun hat.

Die Schwierigkeiten und den größeren Zeitaufwand um RAW sehe ich für mich zudem als weniger problematisch. Vielmehr finde ich, das so nochmal ein klein wenig die Spreu vom Weizen getrennt wird. Nicht jeder beherrscht RAW in seinem vollen Umfang und ist sich dem Aufwand wert. Wer damit nichts anfangen kann, lässt es. Der Rest erfreut sich an den neu gewonnen Möglichkeiten. Was übrig bleibt, wird sich zeigen.

Bei den elendigen Diskussionen in den anderen Threads empfinde ich übrigens ein metaphorisches Bild: Urmenschen die, im Kreis versammelt, das erste Mal vor einem Feuerzeug stehen und stundenlang abwägen, was das wohl ist, wie man es nutzt, ob es was bringt, wem es was bringt, und, und, und. Und derjenige, der einfach drauf zu geht und es benutzt, ist den anderen schon Meilen voraus, während diese sich immer noch den Kopf zerbrechen...

Antwort von Joggel:

ja genau: als ich vor 30 Jahren 16mm gefilmt habe, hat jede Sekunde einen Euro gekostet. Mit den neuen 1000x Karten ist es wieder so :-)

Antwort von Tiefflieger:

Aber der Kontrastumfang ist trotz RAW bescheiden und keine Zeichnung oder Details in Schatten.

Im Zeitindex 3:01 links oben in den Baumschatten gibt es Schwarz-Rauschen.

So wäre die Kamera nichts für mich.

Da kann ich dir gerade nicht ganz folgen. Also du schlussfolgerst anhand dieses Video auf den Kontrastumfang vom Canon RAW? Wer weiß denn schon, welche Einstellungen Andrew Reid dort genau vorgenommen, was er inwiefern korrigiert und gegradet hat. Ich habe hier jedenfalls unangepasstes DNG rumliegen, wo sehr wohl noch Zeichnungen und Details in den Tiefen vorhanden sind. Also davon würde ich das nicht abhängig machen.

...

Ich bin gespannt auf Deine Ergebnisse, sofern Du etwas zeigen kannst und willst :-)

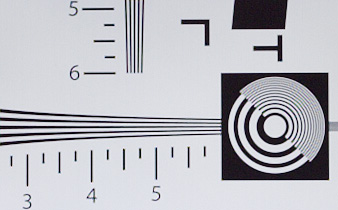

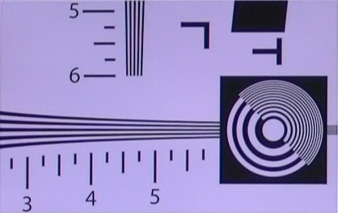

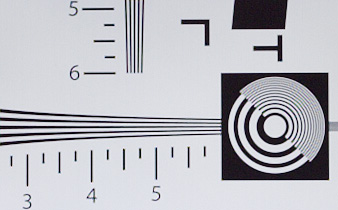

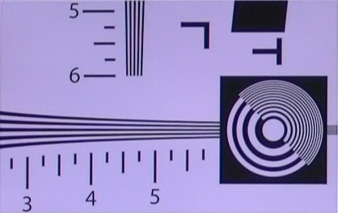

Ich habe ein paar Standbilder aus dem MP4 Download im Eingangs-Artikel rausgezogen.

Von links nach rechts.

Das 1. Bild der dunkle Bereich rechts ist "schwarz" ohne Zeichnung

Das 2. Bild ist vermutlich unterbelichtet und die Bäume sind fast Matsch

Das 3. Bild würde man vermutlich die Musterung der dicken Äste im unteren Bereich noch sehen

Im 4. Bild Zeitindex 3:01 (Filmende) im roten Rahmen gut zu sehen ist das Grün verrauscht.

zum Bild http://www.fotos-hochladen.net/thumbnail/canoneosmk300jo7uxib2fy_thumb.jpg /

/

zum Bild http://www.fotos-hochladen.net/thumbnail/canoneosmk302m2gyqksdwn_thumb.jpg /

(click)

Gruss Tiefflieger

Antwort von iasi:

Wer die 5dIII schon besitzt oder sie eh fürs Fotografieren kaufen möchte, kann sich freuen.

Ansonsten bin ich doch noch sehr skeptisch.

Im Full-Frame-Modus wäre sie wirklich etwas besonderes, im Crop-Modus stellt sich jedoch die Frage: Gibt es da nicht bessere Alternativen?

Insgesamt ist es wohl noch ein ziemliches Gewürge.

Könnte die Kamera 25fps in der niedrigeren RAW-Auflösung als Reihenaufnahme auf die Karte schreiben, wäre das eine feine Sache - so gibt es ja z.B. S-RAW mit 2.880 x 1.920 und bei voller Auflsösung schafft die Kamera 6fps. So aber ...

Die EOS 1D-X sollte bei (S-RAW) 2.592 x 1.728 doch prinzipiell auch in der Lage sein, Reihenaufnahmen mit 25fps zu machen - bei 4-facher Auflösung schafft sie immerhin 12fps. Wobei man dann jedoch bei 180MB/s wäre.

Antwort von domain:

@ Tiefflieger

Stimmt eigentlich.

Ich sehe alles und jedes von dir Analysierte beinahe schon so negativ wie du: alles ohne Zeichnung, unterbelichtet, fast Matsch und alles Grün verrauscht.

Was hast du eigentlich für eine Kamera, wo all das nicht existent ist?

Bisher hast du uns das noch nie verraten.

Antwort von WoWu:

Urmenschen die, im Kreis versammelt, das erste Mal vor einem Feuerzeug stehen und stundenlang abwägen, was das wohl ist, wie man es nutzt, ob es was bringt, wem es was bringt, und, und, und. Und derjenige, der einfach drauf zu geht und es benutzt, ist den anderen schon Meilen voraus, während diese sich immer noch den Kopf zerbrechen...

:-)) ... bis die andern dann zugestiegen sind und denen, die gleich losgefahren sind gesagt haben, dass man am Lenkrad drehen muss, um nicht immer im Kreis zu fahren.

:-))

Antwort von iasi:

Aber der Kontrastumfang ist trotz RAW bescheiden und keine Zeichnung oder Details in Schatten.

Im Zeitindex 3:01 links oben in den Baumschatten gibt es Schwarz-Rauschen.

So wäre die Kamera nichts für mich.

Da kann ich dir gerade nicht ganz folgen. Also du schlussfolgerst anhand dieses Video auf den Kontrastumfang vom Canon RAW? Wer weiß denn schon, welche Einstellungen Andrew Reid dort genau vorgenommen, was er inwiefern korrigiert und gegradet hat. Ich habe hier jedenfalls unangepasstes DNG rumliegen, wo sehr wohl noch Zeichnungen und Details in den Tiefen vorhanden sind. Also davon würde ich das nicht abhängig machen.

...

Ich bin gespannt auf Deine Ergebnisse, sofern Du etwas zeigen kannst und willst :-)

Ich habe ein paar Standbilder aus dem MP4 Download im Eingangs-Artikel rausgezogen.

Von links nach rechts.

Das 1. Bild der dunkle Bereich rechts ist "schwarz" ohne Zeichnung

Das 2. Bild ist vermutlich unterbelichtet und die Bäume sind fast Matsch

Das 3. Bild würde man vermutlich die Musterung der dicken Äste im unteren Bereich noch sehen

Im 4. Bild Zeitindex 3:01 (Ende) im roten Rahmen gut zu sehen ist das Grün verrauscht.

Gruss Tiefflieger

Anhand der Standbilder kannst du wirklich keine Aussagen machen ... die sagen nichts darüber aus, wieviel Zeichnung in den RAW-Aufnahmen waren.

Antwort von Tiefflieger:

@ Tiefflieger

Stimmt eigentlich.

Ich sehe alles und jedes von dir Analysierte beinahe schon so negativ wie du: alles ohne Zeichnung, unterbelichtet, fast Matsch und alles Grün verrauscht.

Was hast du eigentlich für eine Kamera, wo all das nicht existent ist?

Bisher hast du uns das noch nie verraten.

Im Film hat es auch Szenen mit besserer Zeichnung.

Die Details stimmen und viele Szenen sind gut gezeichnet.

Aber anhand dieses Ergebnisses bin ich kritisch.

Gruss Tiefflieger

Antwort von Tiefflieger:

Aber der Kontrastumfang ist trotz RAW bescheiden und keine Zeichnung oder Details in Schatten.

Im Zeitindex 3:01 links oben in den Baumschatten gibt es Schwarz-Rauschen.

So wäre die Kamera nichts für mich.

Da kann ich dir gerade nicht ganz folgen. Also du schlussfolgerst anhand dieses Video auf den Kontrastumfang vom Canon RAW? Wer weiß denn schon, welche Einstellungen Andrew Reid dort genau vorgenommen, was er inwiefern korrigiert und gegradet hat. Ich habe hier jedenfalls unangepasstes DNG rumliegen, wo sehr wohl noch Zeichnungen und Details in den Tiefen vorhanden sind. Also davon würde ich das nicht abhängig machen.

...

Ich bin gespannt auf Deine Ergebnisse, sofern Du etwas zeigen kannst und willst :-)

Ich habe ein paar Standbilder aus dem MP4 Download im Eingangs-Artikel rausgezogen.

Von links nach rechts.

Das 1. Bild der dunkle Bereich rechts ist "schwarz" ohne Zeichnung

Das 2. Bild ist vermutlich unterbelichtet und die Bäume sind fast Matsch

Das 3. Bild würde man vermutlich die Musterung der dicken Äste im unteren Bereich noch sehen

Im 4. Bild Zeitindex 3:01 (Ende) im roten Rahmen gut zu sehen ist das Grün verrauscht.

Gruss Tiefflieger

Anhand der Standbilder kannst du wirklich keine Aussagen machen ... die sagen nichts darüber aus, wieviel Zeichnung in den RAW-Aufnahmen waren.

Klar es ist ein 8 bit Vimeo Format aber es hat einige Stellen ohne Details in den Tiefen (h.264 mit 24 Mbps sollte besser aussehen). Aber gerade da um etwas RAW Vorteile zu zeigen könnte mit anderem Gamma oder flachem Profil der Tiefenumfang gezeigt werden.

Gruss Tiefflieger

Antwort von iasi:

@ Tiefflieger

Stimmt eigentlich.

Ich sehe alles und jedes von dir Analysierte beinahe schon so negativ wie du: alles ohne Zeichnung, unterbelichtet, fast Matsch und alles Grün verrauscht.

Was hast du eigentlich für eine Kamera, wo all das nicht existent ist?

Bisher hast du uns das noch nie verraten.

Im Film hat es auch Szenen mit besserer Zeichnung.

Die Details stimmen und viele Szenen sind gut gezeichnet.

Aber anhand dieses Ergebnisses bin ich kritisch.

Gruss Tiefflieger

na also - normalerweise lässt sich anhand dieser guten Einstellungen auf die Qualität des RAW-Material schließen. Man kann sowohl bei der Belichtung als auch beim Grading die Möglichkeiten von RAW durchaus beschneiden.

Wer die Lichter clippen lässt oder es andererseits mit dem Schutz der Lichter übertreibt, nutzt den DR nicht richtig aus.

Und wer RAW anhand des Vorschaumonitors beurteilt, liegt häufig daneben - das Histogramm ist der Schlüssel zum Erfolg.

Antwort von glnf:

Das Ausmass dieser Entwicklung ist schon krass. So bedeutet es, dass die Sensoren von Fotokameras offensichtlich schon längst in voller Auflösung und Bildrate ausgelesen werden können, die Hersteller es aber nicht für nötig erachten dies den Anwendern zur Verfügung zu stellen.

Ein schnelles Interface und simpelste Software hätten seit Jahren gereicht um die RAW-Daten extern aufzuzeichnen, mit allen Vorteilen. 2K und 4K Video mit hohem Kontrastumfang ist somit seit langem günstig möglich, wir haben die Geräte quasi in der Hand, es fehlt nur die passende Schnittstelle. Und auch die ist nicht Raketentechnologie. Firewire oder USB 3 reichen aus. Statt dessen werden Jahr für Jahr neue Spezialgammas und "Cinestyles" eigeführt die kompliziert zu verarbeiten sind und doch den Möglichkeiten von RAW heftig hinterherhinken. Weshalb nur? Müssen sich die Fotografen mit verschiedenen Übertragungskurven, Spezialsondergammas und Colorprofiles herumschlagen? Nein. Ihnen wird seit über 10 Jahren RAW gegönnt damit ihnen die bestmögliche Qualität zur Verfügung steht.

Entweder verstehen die Hersteller ihre eigenen Produkte und Kunden nicht oder sie beschneiden ihre Kameras seit Urzeiten gezielt um Verbesserungen nur tröpfchenweise in neue und möglichst teuer Produkte einfliessen zu lassen. Dabei vermeiden Firmen wie Canon, Sony und Panasonic die simple und hochwertige RAW Aufzeichnung und bringen lieber unbezahlbare, komplizierten und inkompatible Produkte auf den Markt. Kein Wunder steht die Türe so weit offen für kleine Firmen wie Black Magic oder eben Coder wie A1ex von Magic Lantern.

Antwort von le.sas:

Im Endeffekt ist es doch so wie vor 4 Jahren: Es gibt einen riesigen geilen Sensor, alles was noch gemacht werden muss, ist das Signal abzugreifen. Das hätte man auch schon vor 4 Jahren machen können.

Ich finde es immer etwas kritisch, sich über technische Dinge auszulassen, die gerade noch in der Entwicklung sind, und dann noch anhand von Internetvideos oder Bildern..

Man analysiert ja auch nicht einen Kuchen der noch nicht im Ofen war, oder?

Ich finde dass es natürlich kein Überfliegermaterial ist, aber wovon reden wir hier?

Es ist ein Fotoapparat, der jetzt fast so gute Qualität wie eine C300 hat, und das im, und ich betone es nochmals, Entwicklerstatus!

14 Bit Material ist su super zu graden, das ist unglaublich wenn man das mit dem h.264 Material vergleicht. Wenn man ein bißchen mit Camera-Raw gearbeitet hat, bekommt man wirklich guten Scheiß aus dem Material, das ist unglaublich.

Und noch eine kleine Ergänzung zum Speicherbedarf-

Es wird gerade an einem Skript gearbeitet, das scheinbar doch in den Prozessor eingreift und das Material komprimieren kann- und zwar die Farbtiefe und somit die Bitrate.

Was das heißt (wenn es denn so funktioniert), dass man statt 14 eben in 12 oder 10 Bit aufnimmt (was mehr als ausreichend ist), was erstens die Bitrate senkt (und somit auch das Aufnehmen mit langsameren Karten ermöglicht), und die Aufnahme von höhern Auflösungen über 2K.

Was mich mal interessieren würde (@Slashcam)-

ich hab bisher einen einzigen Ebayanbieter (der kommt mir relativ spanisch vor) und Komputerbay selbst bei Amazon (da gibt es die karte für 150 aus US and the A) gefunden für die 64er Version.

Habt ihr noch alternativen wo man die bekommen könnte...?

Antwort von rudi:

Es wird gerade an einem Skript gearbeitet, das scheinbar doch in den Prozessor eingreift und das Material komprimieren kann- und zwar die Farbtiefe und somit die Bitrate.

Was das heißt (wenn es denn so funktioniert), dass man statt 14 eben in 12 oder 10 Bit aufnimmt (was mehr als ausreichend ist), was erstens die Bitrate senkt (und somit auch das Aufnehmen mit langsameren Karten ermöglicht), und die Aufnahme von höhern Auflösungen über 2K.

Hast du da nen Link? Ich hatte das nämlich A1ex vor einer Woche oder so im ML Forum vorgeschlagen und er meinte, dass nur die Emdac-Routinen so schnell kopieren können, dass RAW überhaupt geht. Und die Emdacs kann man kaum programmieren. Drum würde es mich interessieren, wie der emdac jetzt umschifft werden soll.

Was mich mal interessieren würde (@Slashcam)-

ich hab bisher einen einzigen Ebayanbieter (der kommt mir relativ spanisch vor) und Komputerbay selbst bei Amazon (da gibt es die karte für 150 aus US and the A) gefunden für die 64er Version.

Habt ihr noch alternativen wo man die bekommen könnte...?

Leider nein, wir haben auch selber keine, sondern nur Andrew, der unseres Wissens nach bei amazon gekauft hat.

Antwort von glnf:

Ich finde dass es natürlich kein Überfliegermaterial ist, aber wovon reden wir hier?

Also ich finde die Qualität schon recht überfliegermässig.

Ist ja bezüglich Farbe und Kontrastumfang genau das selbe was die Kamera im Stillmodus leistet. (Abgesehen von einem Minidetail welches aber kaum eine Rolle spielt.)

Antwort von le.sas:

Jo klar:

http://www.magiclantern.fm/forum/index. ... n#msg39196

Da ist ein neuer User gestern mit angekommen.

Aber ich glaube man sollte lieber noch nicht die Pferde wild machen...

Und wegen der Karte- danke, denke mal dass da in letzter Zeit viele Bestellungen eingingen, deßhalb ist sie so schwer zu bekommen.

150 Euro ist aber schon ne Hausnummer für so ne "Billigkarte".

Aber sieht für mich gerade nach der besten Alternative aus.

Ich teste nachher nochmal ne Sandisk 32er 90MB/s, aber die komputerbay mit ihren über 90 MB/s ist schon sehr nice. Allein die Ausfallrate von der alle reden nervt etwas...

Wahrscheinlich müssen von allen gängigen Karten erstmal Benchmarks gemacht werden, meine Lexar 1000x schafft zb auch nur 74 MB/s, was leider etwas wenig ist.

Antwort von krissto:

zur Speicherkarte: Habe letzte Woche noch eine 64 GB Karte von Komputerbay für 99 Euro bei Amazon bestellt, kam gestern an, insofern einfach ein zwei Wochen warten, dann sind die wahrscheinlich wieder auf Lager... Gruß Krissto

Antwort von ruessel:

Habe ich Tomaten auf den Augen? Die Auflösung ist doch noch unter einem vernünftigen AVCHD Camcorder zum viertel Preis. Ich verstehe die ganze Aufregung nicht....

Wann zeigt Slashcam mal die rechte Seite des Charts? Max. 600 LPH ist doch schon seit 8 Jahren kalter Kaffee.

Antwort von le.sas:

Haha da hatte ich sie auch noch gesehen... hätte ich mal zugeschlagen.

Dank dir für den Tip!

Antwort von le.sas:

Unglaublich wie alle immer auf die Auflösung abgehen, in einer Youtubewelt.

Das Alleinstellungsmerkmal ist keine 8 Bit mehr zu haben.

Wer sich ein bißchen damit auskennt, weiß sofort um das Potential von mehr farbtiefe.

Alle anderen zählen halt weiterhin brav jedes einzelne Pixel...

Antwort von ruessel:

Wer sich ein bißchen damit auskennt, weiß sofort um das Potential von mehr farbtiefe.

Gähn.....

Antwort von le.sas:

Ok, das Gähn zeigt uns ja gerade dass du zu denen gehörst, die sich nicht auskennen.

Ist ja furchtbar, auch wenn du arrogant rüberkommen möchtest, klappt das leider nicht so.

Also schreib entweder was produktives oder am Besten gar nichts zu dem Thema, wenn du eh denkst dass das alles Unsinn ist.

Antwort von mella:

Klar, und so ein Look geht sicher auch mit einer anderen Videokamera für 2700 Euro:

Vielleicht mit der BMCC, aber selbst da bin ich mir nicht mehr so sicher und außerdem gibts die nicht beim Saturn um die Ecke...

Antwort von WoWu:

Alle anderen zählen halt weiterhin brav jedes einzelne Pixel...

Und wer zählt hier die Bits, die er auf keine Karte mehr bekommt ?

@Ruessel

Die Binnen ja den Sensor schon kräftig, damit ihnen der Prozessor nicht schmilzt.

Da wird das so schnell vermutlich nix mit zeitgemässer Auflösung bei Bewegtbild in vernünftigen Bewegungsphasen.

Da hat meila schon Recht ... sowas gibt's schon... und in guten Frameraten.

Antwort von le.sas:

Ich würde sagen derjenige der was damit anzufangen weiß...

Sorry jungs ich muss wieder aus, drehen.

Ihr könnt ja währenddessen noch ein bißchen zu einem Thema rumnerden dass euch eigentlich gar nicht interessiert.

Antwort von glnf:

... sowas gibt's schon... und in guten Frameraten.

Hallo Wowu, an welche Kameras denkst du dabei?

Antwort von ruessel:

Ok, das Gähn zeigt uns ja gerade dass du zu denen gehörst, die sich nicht auskennen.

Ich habe mich schon gewundert das keine Reaktionen kamen ;-)

Ich denke eine gute Kamera gut abgestimmt, macht auch gute Bilder in 8Bit. Ob auf AVCHD oder MPG2, das Endziel ist bei mir sowieso eine BD in 4:2:0. Und wer beim Filmen seinen Verstand schon einschaltet, kann auch aus normalen AVCHD Farblich noch optimieren.

Ich habe manchmal den Eindruck hier sind nur Leute versammelt, die nicht richtig mit der Blende umgehen können und hoffen später in aller Ruhe anständige Bilder aus suboptimalen Belichteten 12Bit quetschen zu können.

Rolling Shutter bei jeder kleinen Bewegung, eine Auflösung unter HDV aber möglichst 16 Bit... steigert dadurch wirklich die Bildqualität der Produktion gewaltig?

Antwort von WoWu:

@le.sas

Woher willst Du wissen, dass es nicht interessiert ?

Es ist nur sehr schwer zu erkennen, wo die eigentliche Innovation dabei ist.

Es gibt zum identischen Preis Kameras, die mehr als das können (und besser).

Erklär mir doch mal, wo die Innovation ist und was Dich so ausflippen lässt.

Antwort von glnf:

Es gibt zum identischen Preis Kameras, die mehr als das können (und besser).

Und das waren... welche schon wieder?

Antwort von WoWu:

@Ruessel

Etwas mehr als 8 Bit 4:2:0 darf es schon sein. Dagegen wird keiner was haben aber ich glaube, hier wird mal wieder auf RAW "abgefahren" und auf die 16 Bit.

Dass man die 16 Bit nur durch das Bin erreicht und dass dabei die Auflösung auf der Strecke bleibt, wird dabei völlig vergessen.

Ich glaube, das Thema ist euphorisch überbewertet und wird von den Blogs nur hochgepuscht.

Das war bei dem GH2 Hack doch nicht anders, der sich dann als "Maus" entpuppte.

Nice Hack, und wer die MKIII hat, wird ihn sicher nutzen, aber ein Kaufgrund

wäre das für mich nicht.

Antwort von ruessel:

Ich glaube, das Thema ist euphorisch überbewertet und wird von den Blogs nur hochgepuscht.

Ja, das hat mich eigentlich hier im Bericht gestört:

Das haute uns dann doch aus den Socken. Zwar liegt die erzielbare Schärfe nicht ganz an einer C100/300, die natürlich von ihrem für FullHDFullHD im Glossar erklärt optimierten Sensor profitiert. Dennoch liegt die erzielbare Schärfe in diesem Modus definitiv in der DSLR-Oberliga.

Schon eine sehr leichte nachträgliche Schärfung der 8 BitBit im Glossar erklärt Datei zeigt, wie viel Spielraum hier noch im Raw-Material für die Postproduktion enthalten ist. Gepaart mit der beispiellosen Dynamik, die man durch die RAW-Dateien hat bekommt man hier plötzlich eine Kamera, die kaum Konkurrenz neben sich hat.

Und dann werden optimierte Ausschnitte gezeigt, wo ich mich doch schon sehr wundern muss....

Oben ein alter 600,- Euro AVCHD Camcorder für die Hosentasche. Sieht doch der Testchart bis auf den versauten WB ein wenig besser aus.

Antwort von iasi:

Vielleicht bringt dieses 14 zu 12 (10) Bit nochmal Schub in die Geschichte

http://www.magiclantern.fm/forum/index. ... ic=5601.50

Immerhin könnte dies die Datenmengen bei 1920x1080 (+) auf ein Maß reduzieren helfen, das von der Hardware zu bewältigen ist.

Ich hätte ja nichts dagegen, wenn meine 5dII ein bearbeitbares 12Bit-RAW-Format in Full-Frame und/oder Crop-Mode ausspucken würde, welches 1080/25p oder mehr bietet.

Bin mal gespannt.

Ansonsten muss man eben hoffen, dass BMD im Sommer wirklich liefern kann.

Antwort von WoWu:

Vielleicht bringt dieses 14 zu 12 (10) Bit nochmal Schub in die Geschichte

http://www.magiclantern.fm/forum/index. ... ic=5601.50

Immerhin könnte dies die Datenmengen bei 1920x1080 (+) auf ein Maß reduzieren helfen, das von der Hardware zu bewältigen ist.

Ich hätte ja nichts dagegen, wenn meine 5dII ein bearbeitbares 12Bit-RAW-Format in Full-Frame und/oder Crop-Mode ausspucken würde, welches 1080/25p oder mehr bietet.

Bin mal gespannt.

Ansonsten muss man eben hoffen, dass BMD im Sommer wirklich liefern kann.

Die 16 Bit kannst Du ohnehin vergessen, weil 2 Bit davon sowieso nicht nutzbar sind und nur Datenrate verschwenden.

Problem ist eben nur, dass das Binning im Sensor gemacht wird.

Dazu müsste man an die Tabellen, die das sensor-intern treiben.

Da wird es hapern.

Demnach bleiben nur die Konstellationen, die der Chiphersteller implementiert hat.

Antwort von glnf:

Die 16 Bit kannst Du ohnehin vergessen, weil 2 Bit davon sowieso nicht nutzbar sind und nur Datenrate verschwenden.

Ausser ruessel und dir spricht niemand von 16 Bit. Es sind 14 Bits die der AD Wandler liefert und da die letzten 2 Bits, wie du richtig anmerkst, eh Rauschen sind, versuchen die ML Leute gerade die Daten auf 12 bzw. 10 Bis zu beschneiden. Dadurch liesse sich die Datenrate leicht reduzieren. Es wird gerade die Frage geklärt ob sich die benötigte Rechenleistung dazu in der Kamera irgendwo abzwacken lässt.

Antwort von iasi:

letztlich wäre ich mit jeder Verbesserung gegenüber den aktuellen 8Bit 4:2:0 zufrieden - einem geschenkten Gaul schaut man schließlich nicht ins Maul.

Antwort von Valentino:

Aber dann doch nicht gleich RAW,hat hier jemand mal den clear HDMI Out der 5DMK3 ausprobiert, da sollten doch echte 8bit 4:2:2 anliegen oder?

Schon mit einem BM Shuttle hätte man eine deutliche höhere Farbauflösung und geringere Komprimierung.

Durch das ganze RAW Gehype geht diese Funktion völlig unter, und wird für die meisten dazu noch sinnvoller sein als dieser riesiger "RAW-Datengrab-Montser Workflow",

bei dem man nicht sicher sein kann, das es nicht irgendwo Droped Frames oder ähnliches auftritt.

Antwort von WoWu:

Die 16 Bit kannst Du ohnehin vergessen, weil 2 Bit davon sowieso nicht nutzbar sind und nur Datenrate verschwenden.

Ausser ruessel und dir spricht niemand von 16 Bit. Es sind 14 Bits die der AD Wandler liefert und da die letzten 2 Bits, wie du richtig anmerkst, eh Rauschen sind, versuchen die ML Leute gerade die Daten auf 12 bzw. 10 Bis zu beschneiden. Dadurch liesse sich die Datenrate leicht reduzieren. Es wird gerade die Frage geklärt ob sich die benötigte Rechenleistung dazu in der Kamera irgendwo abzwacken lässt.

Sorry, natürlich 14 Bit.

Nur bleibt das Problem, dass sie nicht in die Binningtabellen reinkommen, um grössere Auflösungen, schnell genug zu übertragen.

Antwort von domain:

Ich denke eine gute Kamera gut abgestimmt, macht auch gute Bilder in 8Bit. Ob auf AVCHD oder MPG2, das Endziel ist bei mir sowieso eine BD in 4:2:0. Und wer beim Filmen seinen Verstand schon einschaltet, kann auch aus normalen AVCHD Farblich noch optimieren.

Ich weiß nicht, ob ich bisher was übersehen habe, vielleicht könnt ihr mich aufklären.

Meiner Meinung nach kann selbst bei nur 8Bit bei einer auch noch so starken Farbkorrektur kein Banding entstehen, sofern das Original so ziemlich den gesamten Wertebereich zwischen 16 und 235 umfasste. Erst bei einer massiven Tonwertspreizung eines engen Bereiches wird das sichtbar.

Als Beispiel habe ich hier den links äußersten Bereich des BelleNuit-Graukeiles, also genau die Werte 10-100 auf 0-255 gespreizt. Nun ist leichtes Banding erkennbar, das aber auch nur in größeren eher unstrukturierten Flächen sichtbar würde.

Aber selbst die stärksten anschließenden Farbkorrekturen können das Banding nicht mehr erhöhen.

Es ist m.E. ja eine totale Fehleinschätzung, dass in einer 8-Bitcodierung keine wesentlichen Farbkorrekturen mehr möglich sind.

Antwort von ruessel:

Meiner Meinung nach kann selbst bei nur 8Bit bei einer auch noch so starken Farbkorrektur kein Banding entstehen,

Ich glaube Banding ist auch nicht das Problem. Bei 8 bit ist halt der nachträgliche verschiebbare Kontrastumfang etwas klein. Vergleiche es mit einem guten JPG und einen TIFF Bild. Beim JPG kommen irgendwann Artefakte zum Vorschein beim Tiff nicht so schnell. (ja, der Vergleich hakt ein wenig)

Antwort von glnf:

Da habt ihr schon recht. Die 8 Bits sind grundsätzlich meist ausreichend. Das leichte Rauschen und die Strukturen die reale Bilder immer haben kaschieren zusätzlich potentielle Probleme.

Das tolle an dem Hack und an RAW im allgemeinen ist ja primär der viel höhere Kontrastumfang. Das bedeutet, dass man erst mal sehr "flaue" Bilder erhält die direkt nicht zu verwenden sind. Dafür kann man im Nachhinein präzise steuern ab welcher Helligkeit die Lichter zusammenlaufen sollen und wie viel Details in den ganz dunklen Bildbereichen noch erwünscht sind. Gerade das Beispiel weiter oben mit den Aufnahmen vom Strand zeigen sehr eindrücklich was RAW erlaubt. Immerhin sind die Aufnahmen in praller Sonne gedreht worden und soweit ich es sehen kann wurden keine Reflektoren zum Aufhellen der Gesichter verwendet. Meine (sehr gute) Videokamera würde in der Situation völlig versagen. Es wäre schlicht unmöglich so zu filmen.

Antwort von WoWu:

Dafür kann man im Nachhinein präzise steuern ab welcher Helligkeit die Lichter zusammenlaufen sollen und wie viel Details in den ganz dunklen Bildbereichen noch erwünscht sind.

.....und landen wird man dann bei so etwas wie einer LOG Kurve.

Nein, nein, der eigentliche Vorteil von RAW wird von den meisten gar nicht genutzt.

Er liegt nicht nur darin, 12 Bit vom Sensor zu bekommen sondern darin, dass das Ganze farbraumneutral ist und man durch individuelles Eingreifen ins De-Bayering erst, sowohl eine Farbgewichtung vornehmen kann, als auch individuell Einfluss auf die "Deplatzierung" (nenne ich das mal), der Farbpixel Einfluss hat, um den klassischen Moirebildungen entgegen zu wirken.

Dann erübrigt sich auch meist die Kantenaufsteilung, denen man ohne RAW ausgesetzt ist von allein.

Danach wird man aber genau wieder da landen, wo fast alle LOG Kurven auch gelandet sind.

Wer also den Vorzug von RAW nur nutzt, um es wie LOG zu benutzen, kann auch gleich LOG nehmen. da hat er die ganzen Probleme nicht, die RAW mit sich bringen.

Antwort von glnf:

Seit Jahren frage ich mich, weshalb meine Stills so viel besser sind als meine Videoaufnahmen. Umso mehr, als dass die Stillkamera auch Video aufzeichnen kann. Nur, dass sie dann diesen Schnellwaschgang dazwischen schaltet und die Bilder irgendwie bunt und kontrastreich macht. Das erklärt auch, weshalb Timelapse Aufnahmen so viel besser aussehen als Videoaufnahmen. Eben weil die Kamera sie als Stills und nicht als Video behandelt.

Was will mich da mit LOG herumschlagen. Mit RAW bin ich mehr als glücklich. Abgesehen davon das die LOGs der diversen Hersteller ja vor allem auf Inkompatibilität setzten und oft genug nur für heftige Aufpreise freigeschalten werden. Also mir gefällt die Entwicklung die mit Red angefangen hat, unter anderem von Black Magic aufgenommen wurde und nun auch die Hackerszene antreibt.

Antwort von WoWu:

Da bin ich ja völlig bei Dir, nur dass Du es eben mit Datenmengen (innerhalb eines sehr begrenzten Zeitraums) zu tun hast. Das ist weder bei LOG, noch bei Timelaps und schon gar nicht bei Stills der Fall.

Also geht das hier zulasten der räumlichen Auflösung.

Und eben solche Probleme haben die Hersteller durch eine moderate Kompression und eine geschickte Übertragungskurve gelöst.

Und ich glaube nicht, dass die Hacker das Rad neu erfinden.

Sie kommen an Schnittstellen und den Übertragungsgeschwindigkeiten auch nicht vorbei.

Mal ganz abgesehen davon, dass man im RAW sämtliche Korrekturen, speziell auch im Bereich der Optik, die sonst die Kamera durchführt, alle in der Post-Pro "an der Hacke" hat.

Und was die Kompartibilität angeht .... da ist RAW ja nun der absolute Vorreiter.

Da ist ja gar nichts kompatibel.

Dagegen sind LOG Kurven, weil sie ohnehin im Videobereich liegen ja noch leicht handhabbar.

Ich will gar nichts gegen RAW sagen, wir benutzen es in sehr speziellen Fällen selbst, aber ich wette, dass ML hier keine Revolution auf die Beine stellt. Weil sie die Probleme, die damit verbunden sind, auch nicht so einfach vom Tisch wischen.

Antwort von glnf:

Naja, bei den Fotografen hat sich RAW völlig durchgesetzt. Ich würde mal eher vermuten, dass LOGs (also die logarithmische Abbildung von Werten) ähnlich wie das elende Colorsubsampling (4:2:2, 4:2:0, etc.) primär eine Massnahme zur Datenreduktion ist und keinen weiteren Komfort oder Vorteil gegenüber den ursprünglichen und unveränderten Sensordaten bietet.

Antwort von WoWu:

Nee, LOGs sind NULL Datenreduktion.

Bei Fotografen ist das klar, die machen auch nicht 50 Bilder in der Sekunde.

Nur es gibt eben derzeit rd. 15 verschiedene File Formate. DNG unterstützt wenigstens ein paar davon und fängt so wenigstens das grösste Chaos auf.

Und RED gelingt es auch nur durch Kompression eine halbwegs akzeptable Auflösung nach aussen zu führen.

Es bleibt eben immer dasselbe Problem.

Aber - wie gesagt - ich weiss ja auch RAW sehr zu schätzen und auch damit umzugehen. Nur wird bei solchen Hacks eben das Rad nicht ein zweites Mal erfunden und man sollte eben nicht zuviel davon erwarten.

Wenn man mit den 600+ Zeilen Auflösung auskommt und damit hübschere Bilder macht als zuvor, dann ist das ja schon die halbe Miete.

Nur darf man das nicht mit Kameras vergleichen, die der HD Auflösung (zeitlich und räumlich) entsprechen.

Ich warte jetzt nur noch darauf, dass irgend jemand sagt, dann bräuche man ja keine Alexa mehr. .... Kommt bestimmt noch.

Aber das ist es eben nicht.

Wenn die Kamera die Qualität einer BMCC auch nur annähernd erreicht, kann jeder Besitzer damit mehr als zufrieden sein.

Ich würde da die Erwartungen an den Hack nicht allzu hoch schrauben, dass sich das wesentlich ändert.

Aber, wie gesagt, jeder, der sie hat, wird das gern nutzen, ein Kaufargument ist das aber bei weitem nicht.

Antwort von glnf:

Wenn die Kamera die Qualität einer BMCC auch nur annähernd erreicht, kann jeder Besitzer damit mehr als zufrieden sein.

Momentan scheint die Frage eher zu sein, wie weit die 5D3 die BMCC überholt. Aber mal schauen. Ich bin gespannt. Wenigstens problemlos erhältlich ist die Canon. Und ich brauch keine Ultraspezialweitwinkel. Und, noch besser, ich kann locker mit Blende 5.6 oder 4 arbeiten und erhalte eine Tiefenschärfe vergleichbar mit Filmkameras. Keine superschnelle Objektive nötig dazu. Sie soll auch ganz Lichtstark sein, abgesehen davon. Schon verlockend, nicht?

Antwort von WoWu:

Na eben nicht ... es sei denn, Du brauchst die geringe Tiefenschärfe, die bietet Dir natürlich nur ein Vollformat.

Aber die Empfindlichkeit, ist eben der geringen Auflösung geschuldet. Beides wird nicht gehen.

Die BMCC macht ja auch bei 2k ein Binning und verliert eine Blende, wenn sie voll auflöst.

Das sind eben Dinge, die hängen immer fest zusammen.

Aber ich bin da mit Dir einer Meinung, gegenüber der bisherigen Videoleistung der MKIII ist der Hack ein Fortschritt, sofern man sich wenig Arbeit mit der RAW Verarbeitung macht und mit den kurzen Aufnahmelängen und teuren Speicherpreisen klar kommt.

Aber mit dem Überholen, bin ich nicht so ganz bei Dir.

Aber die Blogs werden Dir da sicher zustimmen, schliesslich ist jeder Click wichtig und ein Fotograf muss nicht unbedingt verstehen, wie ein Sensor funktioniert ...

Antwort von iasi:

Hab ich da etwas verpasst?

Die volle Sensorfläche zu nutzen bringt bei der 5dIII doch so manche Nachteile mit sich - dachte ich zumindest.

Beim 1:1-Crop ist dann aber eben von der einstigen Größe nicht mehr viel übrig.

Nun mal zum Vergleich die BMPC, die es leider noch nicht gibt:

21.12mm x 11.88mm (Super 35)

3840 x 2160

2.5” SSD

Apple ProRes 422 (HQ)

...

und eben ein offener Standard: CinemaDNG RAW

Wenn BMD es diesesmal schaffen sollte, die Liefertermine einzuhalten fällt die Wahl nicht schwer.

Antwort von glnf:

Meanwhile in America: http://www.magiclantern.fm/forum/index. ... c=5601.100

Antwort von WoWu:

@Iasi

Ich kann diese ganzen Bezeichnungen (wie 1:1) Crop nicht wirklich einordnen, weil das zunächst mal leere Worthülsen sind und nirgend belastbar feststeht, was eigentlich dahinter steht.

Ich gehe mal davon aus, dass der Hack die Tabellen im Sensor benutzt, die von Canon beauftragt wurden. Danach wird jeweils nur umgebinned, um eine vergleichbare Datenrate bei den einzelnen Modi zu erreichen.

Wäre das nicht der Fall, wäre das sowieso inakzeptabel.

@Ginf

Das sieht aber höllisch danach aus, als ob die da im Bildprocessing rumstochern ... das hat mit RAW nix mehr zu tun.

(Ich hab das aber nur mal so angelesen ... nicht wirklich intensiv betrachtet.)

Antwort von iasi:

ja - es geht wohl vorran mit 14 zu 12 Bit.

Nur muss es dann eben auch noch das bringen, was man sich erhofft: Höhere Auflösung durch reduzierte Datenmengen.

Das ist alles schon recht nett - aber letztlich läuft es ein wenig auf Flickschusterei hinaus, denn die Kameras sind dafür ursprünglich nicht konzipiert.

Antwort von Angry_C:

ja - es geht wohl vorran mit 14 zu 12 Bit.

Nur muss es dann eben auch noch das bringen, was man sich erhofft: Höhere Auflösung durch reduzierte Datenmengen.

Das ist alles schon recht nett - aber letztlich läuft es ein wenig auf Flickschusterei hinaus, denn die Kameras sind dafür ursprünglich nicht konzipiert.

Da wird einem wenigstens nicht langweilig. 90 % der Leute, die seit 2 Jahren ihre GH2 Hacks testen, haben nicht mehr zustande gebracht als irgendwelche Blumen Closeups aus dem eigenen Garten.

Solange es Spass macht, die Grenzen eines Gerätes auszuloten, ist das doch eine schöne Sache.

Antwort von cantsin:

Mal ganz abgesehen davon, dass man im RAW sämtliche Korrekturen, speziell auch im Bereich der Optik, die sonst die Kamera durchführt, alle in der Post-Pro "an der Hacke" hat.

Das ist aber in der Digitalfotografie ein längst gelöstes Problem, z.B. mit Lightroom/Adobe Camera Raw und DxO Optics Pro, die anhand der in den EXIF-Metadaten abgelegten Objektiv-/Kamerabodykombinationen automatisch die entsprechenden Softwarekorrekturen zuschalten. Gerade DxO holt damit eine fantastische Qualität aus den RAW-Daten. Nichts (ausser natürlich der Verarbeitungsgeschwindigkeit) spricht dagegen, sowas auch bei Video zu implementieren.

Antwort von WoWu:

Das ist wohl richtig.

Nur wenn ich sehe, dass die Meisten hier das RAW Format einfach irgendwo importieren und zu einem halbwegs ansehnlichen Bild machen, dann hab ich doch meine hellen Befürchtungen, dass solche intensiven Bearbeitungen weitestgehend auf der Strecke bleiben.

All die, die sich mit RAW nicht wirklich befassen wollen, sind mit einem LOG deutlich besser bedient .... da ist dann "all-inclusive".

Antwort von iasi:

All die, die sich mit RAW nicht wirklich befassen wollen, sind mit einem LOG deutlich besser bedient .... da ist dann "all-inclusive".

wohl wahr ... und für das Arbeiten mit RAW braucht es dann aber eben auch etwas Fleisch - die 1920x1080 der BM-Pocket sind hierfür z.B. eigentlich auch zu wenig

Antwort von glnf:

@Ginf

Das sieht aber höllisch danach aus, als ob die da im Bildprocessing rumstochern ... das hat mit RAW nix mehr zu tun.

Nana, nichts wildes. Die hacken nur die zwei minderwertigsten Bits ab um ein wenig Speicherplatz und hoffentlich Transferrate zu sparen. Die lustigen Zwischenergebnisse haben offensichtlich damit zu tun, dass entweder die Werte vorzeichenbehaftet sind (?!? ich durchschau diesen Teil auch nicht ganz - sie reden von "Schwarzwert" aber dass kann auch nicht sein ?!?) oder die falschen Bits erwischt werden bzw. der Rest falsch interpretiert wird. Aber eigentlich ganz naheliegend, da die letzten ~2 Bits normalerweise zu vernachlässigen sind und eh nur Rauschen.

Antwort von WoWu:

Tja, das verstehe ich nicht. Normalerweise macht man das in der Quantisierung so dass die Quantisierungsschritte um den Faktor 2^(16-12)=16 größer werden. Die Auflösung würde somit um den Faktor 16 abnehmen.

Das bedeutet, dass am „less significant Bit- Ende“ des Datenwortes Auflösung verloren gehen würde. Reduziert man also das Datenwort von 16 auf 12 Bit, würde Shot-Noise abnehmen, bei gleichzeitiger Beibehaltung der signifikanten, nicht schwankenden Daten.

Aber die werden das schon machen.

Wenn .... ja wenn es nicht so ist, dass sie, ähnlich wie der Russe, nur in irgendwelchen Tabellen hacken. Dann klappt das nicht.

Antwort von iasi:

Wenn es nur besser wäre, als das bisherige 8Bit-Zeug, wäre doch schon viel gewonnen.

Und wenn sich das bisherige Material z.B. in Photoshop wirklich so bearbeiten lässt, wie die RAW-Standbilder, wäre das schon mal ein enormer Schritt.

Nun hab ich leider die 5dII und bekomme nicht die gewünschte Auflösung - Full-Frame geht wohl damit auch nicht (trotz den bekannten Schwächen beim Scaling wäre dies ja auch schon mal etwas.)

Na - mal sehen, was noch kommt.

Antwort von Clemens Schiesko:

Heute konnte ich den RAW-Modus nun endlich auch mal mit meiner 5D Mark III antesten. Dazu habe ich gleich mal eine kleine deutsche Anleitung zur Installation geschrieben, weil auch ich mich erst etwas länger durchs Netz nach brauchbaren Informationen forschen musste.

ANLEITUNG: WWW.SCHIESKO.DE/RAW

Viel konnte ich aber noch nicht testen, was ich morgen aber nachholen möchte. Ein paar Szenen konnte ich aber dennoch einfangen. Dazu mal 5 Beispielframes mit sehr flacher Kurve, wen es interessiert: http://we.tl/xi1lisZbpg

Ansonsten lief mit der Lexar 32GB 1000x alles flüssig im Full-Frame Modus bei 1920x1080 25fps.

Nett finde ich auch, dass man durch Camera Raw gleichzeitig einen guten Rauschunterdrücker oder eine Objektivkorrektur für z.B. Verzerrungen mitgeliefert bekommt.

Antwort von glnf:

Tja, das verstehe ich nicht. Die Auflösung würde somit um den Faktor 16 abnehmen.

Du sagst es. Mit 14 Bit Farbtiefe sind 2^14 also 16384 Helligkeitswerte darstellbar. Pro Kanal bzw. Pixel, versteht sich, wie daraus danach die Farben generiert werden muss in dem Moment nicht interessieren. Schneide ich nun 2 Bits weg bleiben noch 2^12 = 4096 darstellbare Helligkeitswerte. Also Faktor 4 Verlust. Kürze ich von 14 auf 10 Bits ist es Faktor 16. Da die letzten Handvoll Bits nur einen sehr geringen Einfluss auf den dargestellten Wert haben (man denke an Nachkommastellen, die verlieren auch an Bedeutung je weiter hinten sie sind) und vermutlich sowieso keine echten Daten enthalten (sondern Rauschen = zufällige Werte) kann ich getrost darauf verzichten. Bezüglich der Bildauflösung ändert sich natürlich gar nichts - die Anzahl Pixel bleibt gleich.

Antwort von domain:

Wer also den Vorzug von RAW nur nutzt, um es wie LOG zu benutzen, kann auch gleich LOG nehmen. da hat er die ganzen Probleme nicht, die RAW mit sich bringen.

Spezielle Probleme fangen ja schon an. Jasonxinzhou z.B. behauptet, dass das Debayering von BMD demjenigen von Adobe weit unterlegen sei.

Peter Chamberain von BMD meint im Gegenzug, ihr Verwendetes sei das beste der Welt.

http://forum.blackmagicdesign.com/viewt ... f=2&t=1875

Übrigens Ruessel, mir sind die Vorteile von 12-14 Bit RAW sonnenklar, aber es soll nicht der Eindruck stehen bleiben, dass alles bisher in 8 Bit Gefilmte eigentlich zum Vergessen sei.

Wozu hat es bisher denn bei den Profikameras verschiedene Pictureprofile, sowie Knee- und Blackgamma-Einstellungen gegeben?

Antwort von Frank Glencairn:

Wobei sich Chamberlain im Grunde darauf raus redet, daß Resolve das alles in Echtzeit macht.

Antwort von domain:

Was aber nichts anderes bedeutet, als dass eine Foto-RAW-Entwicklung mal grundsätzlich nicht mit Realtime-Cinema-DNG vergleichbar ist.

Das wird man sich merken müssen.

Richtig spannend wird ja auch die Archivierungsfähigkeit der verschiedenen RAW-Formate. Ob die alle später noch lesbar sein werden?

Antwort von iasi:

Was aber nichts anderes bedeutet, als dass eine Foto-RAW-Entwicklung mal grundsätzlich nicht mit Realtime-Cinema-DNG vergleichbar ist.

Warum?

Antwort von domain:

Weil es Chamberlain indirekt gesagt hat und das muss genügen :-)

Sollten einmal, wie von WoWu schon avisiert, verschiedene Debayering-Algorithmen zur Verfügung stehen, dann sehe ich die nächste große Diskussionswelle mit hunderten Beispiel-Frames von Gartenblumen auf uns zukommen.

Also der Stoff wird nicht so schnell zu Ende gehen, direkt ein Glücksfall.

Antwort von WoWu:

@ moin domain,

Ob die alle später noch lesbar sein werden?

ich glaube, wenn überhaupt in Zukunft noch irgend etwas lesbar sein wird, dann die RAW Formate, (sofern sie nicht komprimiert wurden). Ein (für mich) echtes RAW Format besteht aus ein paar Limawerten. Die sind immer irgendwie auslesbar.

Was die Frage nach Echtzeitfähigkeit betrifft, so glaube ich nach wie vor, dass RAW gar nicht für die Echtzeitbearbeitung gedacht ist. Der Anwender denkt das nur.

Die RAW Formate sind für die indirekte Verarbeitung angelegt und in der ist beliebig viel Zeit, auch die rechenintensivsten Algorithmen durchzuführen.

Wenn Resolve das also "realtime" macht, dann ist das kein Prädikat sondern spricht eher gegen Resolve.

Vielleicht dauert es noch eine Weile, bis der User sich an die sample orientierte Verarbeitung gewöhnt hat aber die NLE Hersteller werden alle umstellen. Apple hat ja schon damit angefangen.

Insofern erledigt sich die Frage nach guten oder schlechten Algorithmen und ich sehe da auch nicht die 1000 Blumenbilder (obwohl man ja nie weiss).

Und "den besten der Welt" ... das ist auch wieder so ein Marketingspruch, wenn ich sehe, wie unterschiedlich die einzelnen Algorithmen auf unterschiedliche Bildinhalte wirken.

Was für den einen Bildinhalt sehr gut wirkt, kann für den andern Bildinhalt schon wieder ungeeignet sein.

Es wird vermutlich einen Haufen guter Stenciles (Tools) geben, die die wichtigsten Aufgaben und Analysen zukünftig im De-Bayering wahrnehmen.

Antwort von cantsin:

Weil es Chamberlain indirekt gesagt hat und das muss genügen :-)

Ich glaube, das hast Du missverstanden. Er bezog sich auf das Real Time-Debayering beim Abspielen von RAW-Material in Resolve, das mit qualitativ schlechteren Algorithmen ausgeführt wird. Sobald man rendert, greifen die Algorithmen die laut seinen Aussagen Hollywood bisher höchst zufriedengestellt haben.

Antwort von domain:

Dann werden es halt keine Blumenbilder, sondern Moire- und Aliasingclips sein.

Hast du nicht neulich etwas von die Pixel rein rechnerisch dislozierenden Debayeringverfahren geschrieben? Man stelle sich vor, diese gäbe es in verschieden starken Ausprägungen, mal mehr scharf mit Aliasing, dann wieder unschärfer ohne Aliasing.

Das würde doch unheimlich viel für Diskussionen und Vergleiche hergeben :-)

Antwort von domain:

Habe mal kurz nach Debayeringverfahren gegoogelt.

Ziemlich schnell kam folgende sicher nicht vollständige Liste zusammen: VNG, PPG, Gradientenverfahren, Bilinear, WACP .... wobei erwähnt wird, dass nach Bildanalyse auch verschiedene Verfahren innerhalb eines Bildes zur Anwendung kommen können, abhängig von mehr geschlossenen Flächen oder mehr Details im Bild.

Es kann bei der RAW-Entwicklung also davon ausgegangen werden, dass es schon auf der Debayeringebene kein einheitliches Verfahren geben wird und gewisse Qualitäts-Debatten entbrennen werden.

Antwort von WoWu:

.... und die sind zum Teil erheblich.

Wie gesagt, wir setzen unterschiedliche Verfahren, je nach Bildbeschaffenheit ein.

Es macht keinen Sinn, sich mit Bildgestaltung, Optiken und sonstigen Bearbeitungen viel Mühe zu geben, wenn man an der Stelle, an der man die Bildqualität ganz wesentlich beeinflussen kann und die Nachteile des Abtastverfahrens deutlich kompensieren kann, nicht eingreift.

Aber ich glaube, dass die 8/10 Bit für die normale Anwendung noch lange erhalten bleiben, denn man darf nicht vergessen, dass jedes Tool, jder Effekt, alles, was man in der Bildverarbeitung zur Anwendung bringt, auch in 12 Bit ausgelegt sein muss, sonst "springt" das Bild an der Stelle sowieso.

Die meisten NLEs und Tools/Effekte dafür sind derzeit noch 8 Bit. Vielleicht 20% sind 10 Bit und ein ganz geringer Teil ist überhaupt 12 Bit fähig. dafür legt man aber für einen solchen Effekt mal eben 500$ auf den Tisch, wie gesagt, ein Effekt/Tool.

Das vergessen die Meisten in der 12Bit Euphorie. Solange sie ein paar harte Schnitte machen, geht das, aber wehe, wenn das Material dann, wie gewohnt, bearbeitet werden soll .... dann wird alles plötzlich wieder 8 Bit.

Viele, von denen, die jetzt 12 Bit (oder mehr) so hypen, können es gar nicht gebrauchen.

Antwort von benjolino:

hallo,

was glaubt ihr, wie das encodieren bei der mk3 passiert? ist das ein hardware encoder oder wäre es möglich die encodierung bzw. komprimierung zu ändern bzw zu verringern. ich frage nur weil ich die hoffnung habe, dass magic lantern es irgendwann schaffen ein anständiges signal aus dem hdmi ausgang zu bekommen und man nicht mehr mit diesen wahnsinnig grossen raw Daten arbeiten muss. was ich nicht verstehe ist, dass das bild im raw format viel detailreicher ist. kann das von der komprimierung kommen, dass das bild unscharf wird? klar Artefakte und banding usw. schon aber Auflösung? oder komprimiert die original 5d mk3 nur 720p oder noch weniger zeilen zu dem all-i codec. ich verstehe einfach nicht wie z.b. die c300 mit 50mbit ein so schönes bild machen kann und die mk3 mit 90mbit so nen matsch. und jetzt da wir wissen, das das bild wenn es roh aus dem sensor kommt so gut ist, ist es umso schwere zu verstehen. in vielen foren wird über canon geschimpft weil sie angeblich absichtlich ihre produkte verkrüppeln um den eigenen markt zu schützen. bei der mk3 liegt der gedanke nicht so fern, zumindest wenn man sich nicht mit encodierung auskennt. mich würde interessieren was du davon hältst bzw. wie du dir erklärst das canon 6 monate an einem sauberen hdmi signal arbeitet und dann ist es kaum besser als der interne codec. machen die das absichtlich so schlecht? sind sie unfähig? oder kann man aus dem ding nicht mehr rausholen? man müsste doch das raw signal irgendwie in leichter komprimierung an den hdmi Ausgang bringen können? ich meine das raw signal liegt doch auch am internen screen an wenn live view aktiviert ist, warum kann es dann nicht auch am hdmi ausgang anliegen?

Antwort von le.sas:

Ich will es mal auf das simpelste runterbrechen: Dslrs sind Fotoapparate.

Die C300 Linie wird sich Canon nicht kaputt machen wenn sie die Funktionen der 5d freischalten. Warum das so ist und warum eine c300 besser zum Drehen zu gebrauchen ist als eine dslr werde ich hier lieber nicht erklären, sonst geht der Kindergarten mit einigen schon wieder los.

Das "Problem" ist, dass es beim raw usw zb zu viele Unkonstante gibt. Warum sollte sich das Canon antun, ständig Mails von Benutzern zu bekommen bei denen was nicht geht, und die in der Post nicht klar kommen.

Deßhalb, und weil die Videofunktion einer dslr eher für Papi gedacht ist der im Urlaub filmen will, ist das Video so kacke. Der braucht nur den h.264 Matsch der einfach zu schneiden ist.

Dass es geht zeigt der Hack der 50d , die jetzt auch RAW kann (wtf?!)

Canon ist übrigens der einzige Hersteller der relativ loyal mit dem Thema Hacks umgeht was die Garantie angeht, anders als Nikon und Panasonik.

Antwort von iasi:

Das "Problem" ist, dass es beim raw usw zb zu viele Unkonstante gibt.

Woher hast du das denn?

Dann müste Canon auch die RAW im Fotomodus abschalten.

Das Problem ist doch schlicht und einfach, dass die Hardware mit RAW überfordert ist. Das hat doch nichts mit RAW an sich zu tun.

Antwort von benjolino:

also ich glaub ihr habt beide unrecht:) die grösste leitung für eine kamera ist das komprimieren von raw Daten. das ist das beste was red kann und desshalb braucht die red epic auch 100 watt und wird heiss wie ein Bügeleisen und laut wie ein staubsauer. bei magic lantern ist ja auch zu lesen, dass beim schreiben von raw daten auf cf karte kaum prozessorleistung benötigt wird. da ist eher das problem, dass man mit den datenmengen an die grenzen der cf Schnittstelle, bzw. der cf karte kommt. wenn nun also das komprimieren vom raw zum h.264 den prozessor beschäftigt, ist für mich die frage, ob das was dabei rauskommt das beste ist was bei der 5d möglich ist. eigentlich, von der datenmenge die produziert wird (90mbit) sollte das bild eigentlich ganz gut sein ( vergleich c300 50 mbit oder fs 100 25mbit) aber die details fehlen. wenn es aber möglich wäre das raw Signal in den hdmi ausgang zu schicken, würde ja ein externer Recorder die komprimierung übernehmen und man könnte ein wunderhübsches proess hq bekommen.

Antwort von iasi:

viele "wenn"

Die Kameras geben all dies hardwaremäßig nun mal nicht her - daraufhin wurden sie nicht konstruiert.

Heiss und laut ist die Epic vor allem wegen ihrer Lüfterkonstruktion - da gibt es ja nun sogar von Red selbst Abhilfe.

Antwort von le.sas:

Das "Problem" ist, dass es beim raw usw zb zu viele Unkonstante gibt.

Woher hast du das denn?

Dann müste Canon auch die RAW im Fotomodus abschalten.

Das Problem ist doch schlicht und einfach, dass die Hardware mit RAW überfordert ist. Das hat doch nichts mit RAW an sich zu tun.

Das ist doch offentsichtlich.

raw Video ist ja was anderes als Raw Fotos.

Guck dir doch mal an, wieviele hier im Forum ständig Fragen zu Raw Video stellen, obwohl sie sich einfach nur den Thread auf der ML Seite durchlesen müssten.

Und jetzt stell dir mal den Pappi von nebenan vor, der wäre total überfordert.

Und was will der dann mit dem raw Material? Umwandeln? Womit? Wie will er die großen Datenmengen handeln?

Mit den Fotos ist es doch was ganz anderes, und ich wiederhole mich gerne, es handelt sich um Fotoapperate, nicht um Videokameras.

Antwort von benjolino:

Das "Problem" ist, dass es beim raw usw zb zu viele Unkonstante gibt.

Woher hast du das denn?

Dann müste Canon auch die RAW im Fotomodus abschalten.

Das Problem ist doch schlicht und einfach, dass die Hardware mit RAW überfordert ist. Das hat doch nichts mit RAW an sich zu tun.

Das ist doch offentsichtlich.

raw Video ist ja was anderes als Raw Fotos.

Guck dir doch mal an, wieviele hier im Forum ständig Fragen zu Raw Video stellen, obwohl sie sich einfach nur den Thread auf der ML Seite durchlesen müssten.

Und jetzt stell dir mal den Pappi von nebenan vor, der wäre total überfordert.

Und was will der dann mit dem raw Material? Umwandeln? Womit? Wie will er die großen Datenmengen handeln?

Mit den Fotos ist es doch was ganz anderes, und ich wiederhole mich gerne, es handelt sich um Fotoapperate, nicht um Videokameras.

raw video und raw Foto ist nichts anderes. das sind halt 24 raw bilder pro Sekunde. ausserdem interessiert mich wenig was pappi von nebenan macht. natürlich hat canon keinen grund raw in der 5d freizuschalten und ja es ist ein Fotoapparat, aber das ist ja kein Hindernis sich über andere Möglichkeiten der benutzung gedanken zu machen. ausserdem weiss canon genau wofür viele die mk3 benutzen, fürs filmen. das haben sie glaube ich seit der mk2 verstanden, sonst wären sie ganz schön doof.

Antwort von le.sas:

ein Raw Foto ist 35 MB groß, ein RAW Video steht in keinem Verhältnis dazu. Kaum ein Normalo hat die Kapazitäten, dies zu bearbeiten.

Und wie geschrieben, dass bei Canon im Vergleich zu den anderen Firmen die normale Garantie nicht erlischt, auch wenn ML zusätzlich benutzt wird, zeigt doch schon dass sie darum wissen und es akzeptieren. Könnten ja auch sagen nein, das wollen wir nicht.

Antwort von benjolino:

full hd sind ca. 2 megapixel. der 5d sensor hat 23 mP. natürlich sind 23mp mehr als 2. deshalb ist ein raw Foto grösser als ein raw video bild. wenn man beim video die 23 mp auslesen würde, wärs genauso gross...

Antwort von le.sas:

Och komm schon, wir sind doch nicht im Kindergarten hier.

Was willst du mit einem einzelnen RAW Standbild?

Ein RAW DNG ist 4 MB groß, 100 MB pro Sekunde und 6 GB pro Minute.

Jetzt kannst du dir ausrechnen wieviel Speicher man braucht für ein Video.

Und wenn wir jetzt wieder beim Urlaubsvideo sind, da filmt man gerne mal 3-4 Std am Tag.

Antwort von glnf:

Jetzt kannst du dir ausrechnen wieviel Speicher man braucht für ein Videos. Und wenn wir jetzt wieder beim Urlaubsvideo sind, da filmt man gerne mal 3-4 Std am Tag.

Natürlich hast du recht. Nur, wer spricht hier von Urlaubsvideo? Selbst im Broadcastbereich wäre der Einsatz von RAW nicht nur der völlige Overkill sondern schlicht nicht zu handhaben. Aber sowohl Urlaubsfilmer wie Broadcaster ziehen auch nicht mit einer Alexa oder Red los. Bei der SLR RAW Filmerei geht es aber genau um die Anwendungen bei denen landläufig Alexas und Reds zum Einsatz kommen. Und qualitativ sind die RAW SLRs mit den Profikameras auf Augenhöhe. Klar, wenn eine 20-Köpfe Filmcrew dabei steht oder das Model 50'000 am Tag verdient riskiert keiner mit einer gehackten Kamera zu arbeiten. Es gibt aber genügend Situationen in denen eine RAW SLR ideal ist, und sei es nur, weil sie mit dem Stuntauto in die Tiefe rauscht. Oder für eine unterfinanziertes Liebhaberprojekt.

Antwort von WoWu:

Na ja, die Alexa hat aber auch keine Probleme, die Daten wegzuspeichern. Das ist bei RAW-SLR schon etwas anders, wenn man jeden Augenblick mit einer Kernschmelze rechnen muss. :-)

Antwort von le.sas:

Da sprichst du komplett die Wahrheit.

Ich hab ja auch lediglich drauf geantwortet, warum Canon das nicht freischaltet- und da hast du gerade die beste Antwort gegeben, wie ich oben übrigens auch schon- es fallen einfach zu viele Daten an, und raw richtet sich an den Profifilmer. Warum sollte das also in einem Fotoapparat, der nicht zum Filmen gedacht ist, eingebeut werden- damit häufen sich die Support Anfragen ohne Ende, und vielleicht haben sie schiss sich die c Linie kaputt zu machen.

Und alle die einigermaßen fit im Lesen sind und ambitioniert, werden es auch so mit ML schaffen.

Antwort von iasi:

Ich lese immer mal wieder, was im ML-Forum so geschrieben wird.

Einen Über- und Einblick habe ich dennoch irgendwie nicht.

Soweit habe ich das bisher verstanden (bezogen auf die 5dII):

- Bei der 5dII ist das Contoller-Limit bei 60-65MB/s

- 1880 horizontal sind ebenfalls ein Limit

- mehr als 1880x840 geht kaum

- Es gibt dan und wann merkwürdige Bildfehler

- 14 zu 12Bit steckt in einer Sackgasse.

Mir ist noch nicht einmal klar, ob es bei der 5dII einen Full-Frame-Modus wie bei der 5dIII gibt.

- Die 1000x-Kartenpreise haben enorm angezogen - Angebot und Nachfrage - Komputerbay freut"s.

- Es stellt sich die Frage, ob die schnellsten Karten in der 5dII überhaupt richtig gefordert werden.

Antwort von le.sas:

Vielleicht würde bei der MkII diese Jpeg Sache Sinn machen.

Allerdings verliert man dadurch die tollen Gradingmöglichkeiten..

Antwort von Clemens Schiesko:

Nett finde ich auch, dass man durch Camera Raw gleichzeitig einen guten Rauschunterdrücker oder eine Objektivkorrektur für z.B. Verzerrungen mitgeliefert bekommt.

...und ein gutes Retuschewerkzeug. Zu mindestens was feste Kameraeinstellungen angeht. Fand ich recht beeindruckt, was innerhalb einer Minute möglich war, wo ich im NLE sonst recht lange gesessen hätte (wenn man bedenkt, dass es bei der Aufnahme zusätzlich geregnet hat). Wer einen kurzen Einblick in Bewegtbild haben möchte, darf es sich gerne anschauen ;)

Video (MP4): http://we.tl/XT2TBxISgI

Edit: Das Hinzufügen (von z.B. Fenster) macht sogar beinah noch mehr Spaß als das Entfernen, hehe.

zum Bild http://s1.directupload.net/images/130529/ctyulfns.jpg

Antwort von iasi:

Vielleicht würde bei der MkII diese Jpeg Sache Sinn machen.

Allerdings verliert man dadurch die tollen Gradingmöglichkeiten..

Was wäre denn mit Jpeg gewonnen?

Antwort von le.sas:

Eine viel geringere Datenrate und kleinere Endfiles. Das hieße im Umkehrschluss dass man rein theoretisch auch größere Auflösungen nehmen könnte (im Falle der MK III jedenfalls)

Antwort von WoWu:

tja, aber 8 Bit .... ist das der Sinn der ganzen Sache ?

Antwort von le.sas:

Dann ist jedenfalls für alle was dabei-die einen die denken dass eine hohe Auflösung wichtig ist bekommen dann ihre Jpegs(da Farbtiefe ja eh nicht wichtig ist), und diejenigen die wissen wie wichtig Farbtiefe ist scheißen auf Auflösung und haben schönstes 12Bit Videomaterial.

Antwort von WoWu:

Oder anders herum ... es ist für niemanden etwas Richtiges dabei.

Nicht Fleisch und nicht Fisch. Nur teuer Speicherkarten, kurze Sequenzen und viel Ärger.

Nee, danke, das kann's ja nun wirklich nicht sein.

Antwort von iasi:

Oder aber man greift zu einer Kamera, die diese Kompromisse nicht erforderlich macht.

Bis ML-Raw sicher läuft gibt es z.B. auch die 4k-BM-Kamera - und die kann dann eine höhere Auflösung und RAW.

@WoWu

da muss ich dir leider Recht geben - "leider", da ich eine 5dII besitze.

Antwort von WoWu:

Aber die macht ja auch sehr schöne Fotos, das wird manchmal bei all dem Bastelkram völlig vergessen.

Und ich finde den "normalen" Video-Look der MKII übrigens auch nicht schlecht.

Antwort von DeeZiD:

Und ich finde den "normalen" Video-Look der MKII übrigens auch nicht schlecht.

Sorry, aber nachdem ich mit der RED und jetzt mit der BMCC arbeiten durfte, finde ich diesen mehr als einfach nur schlecht... :D

Ist doch schön, dass man nun mit der 5D MKIII ein Videobild erzeugen kann, welches sich wunderbar mit dem der BMCC mischen lässt (bis auf den Kontrastumfang von ca. 11,5 Blenden). :)

Antwort von WoWu:

Na ja, bezüglich der RED kann man ja auch getrost geteilter Meinung sein.

Aber Du darfst auch nicht vergessen, dass das auch unterschiedliche Ligen sind.

Antwort von le.sas:

Glücklicherweise zwingt euch niemand, damit zu drehen.

Ich erinnere nur an eine 70mm Imax Produktion- 3 Min drehen, 30 Min Material wechseln... auch das funktioniert.

Aber man muss natürlich den Einsatzzweck sehen-

wenn ich nur Konzerte filme oder den Bäcker von nebenan, wäre mir das auch zu kompliziert mit diesem Workflow.

Antwort von iasi:

Aber die macht ja auch sehr schöne Fotos, das wird manchmal bei all dem Bastelkram völlig vergessen.

auch hier stimme ich dir zu - die 5dII ist eine tolle Fotokamera - daher kam bei mir bisher auch gar kein Bedürfnis für ein Upgrade auf.

Antwort von iasi:

Ist doch schön, dass man nun mit der 5D MKIII ein Videobild erzeugen kann, welches sich wunderbar mit dem der BMCC mischen lässt (bis auf den Kontrastumfang von ca. 11,5 Blenden). :)

Wozu brauche ich dann aber eine 5dIII, wenn ich eh schon eine BMCC habe?

Antwort von glnf:

Schon klar, wer eine BMCC bereits hat muss sich nicht um die 5D3 kümmern. Wozu auch. Wer jedoch (noch) keine BMCC hat für den könnte die Canon aus verschiedenen Gründen zu einer Alternative werden.

Antwort von DeeZiD:

Schon klar, wer eine BMCC bereits hat muss sich nicht um die 5D3 kümmern. Wozu auch. Wer jedoch (noch) keine BMCC hat für den könnte die Canon aus verschiedenen Gründen zu einer Alternative werden.

Das wollte ich damit sagen. Außerdem kann ich nun mit Kameraleuten zusammen arbeiten, die eine 5D MKIII einsetzen ohne nachher mit Entsetzen feststellen zu müssen, wie schrecklich das Bild im Vergleich zur BMCC aussieht. ;)

Antwort von DeeZiD:

Na ja, bezüglich der RED kann man ja auch getrost geteilter Meinung sein.

Sorry wegen OFFTOPIC:

Weshalb? Meiner Meinung nach hat die RED EPIC folgende Probleme:

Farbwiedergabe mittelmäßig (die BMCC produziert einfach schönere Farben, alleine die Hauttöne sind fantastisch)

Probleme bei Kunstlicht (hübsches blau-gelbes Chromarauschen)

Lässt sich aber in der POST eigentlich ganz gut in den Griff bekommen.

Dafür kämpft die BMCC mit farbigen Moirés (auch im Gegensatz zur 5D MKIII)

Antwort von iasi:

Na ja, bezüglich der RED kann man ja auch getrost geteilter Meinung sein.

Sorry wegen OFFTOPIC:

Weshalb? Meiner Meinung nach hat die RED EPIC folgende Probleme:

Farbwiedergabe mittelmäßig (die BMCC produziert einfach schönere Farben, alleine die Hauttöne sind fantastisch)

Probleme bei Kunstlicht (hübsches blau-gelbes Chromarauschen)

Lässt sich aber in der POST eigentlich ganz gut in den Griff bekommen.

Dafür kämpft die BMCC mit farbigen Moirés (auch im Gegensatz zur 5D MKIII)

hmm ... dafür hat man doch RAW - eben damit man in der Postpro das Bild "entwickelt".

Probleme bei Kunstlicht sollten doch nicht verwundern - die Epic hat einen 5000 Kelvin-Sensor. Filter sind immer gut.

Antwort von WoWu:

Ja, nur um das farbige Moire, kommt man auch bei RAW nicht drum herum, weil es durch die Unterabtastung von R und B entsteht.

Und gegen das Problem kämpfen alle 1-Chip (nicht s/w) Kameras.

Antwort von iasi:

Rauschen im Walde!

Richtig extrem ist das Rauschen bei 1:1-Aufnahmen (unter Verwendung von 5x).

Das hat mich doch ziemlich überrascht.

Moirés und und und kommen noch hinzu - zumindest bei der 5dII.

Mag ja sein, dass dies alles bei der 5dIII besser ist, meine Tests mit der 5dII liefen bisher eher ernüchternd.

Antwort von iasi:

War"s das schon mit ML RAW?

So recht verwundern will mich dies nicht, denn bei einem aktuellen Post im ML-Forum ist dies zu lesen:

"Record fews seconds and stop every time you skip frames, record again and stop until the MKIII will start to record with no skipping and from that point on you can stop and record anytime with no skipping. Fantastic!"

Mir wäre dies zu umständlich und vor allem zu unsicher.

Die 12Bit-Raw-Geschichte hat sich wohl auch erledigt.

Somit bleiben also bei meiner 5dII für einige Sekunden 1880x940/25fps ... na ja - immerhin ... das Bearbeiten in Photoshop ist ja zudem sogar recht nett ...

Da kommen mir gerade zwei Fragen zur 5dII:

1. Objektiv-Stabis funktionieren auch bei RAW-Recording?

2. Lässt sich die Kamera bei RAW-Recording auch via USB steuern?

Eben wie bei "normelen" Videoaufnahmen?

Antwort von le.sas:

Naja was heißt war s das schon...

ML Raw gibt es noch nicht, das vergesst ihr immer. Es wird uns lediglich die Möglichkeit gegeben, Teil des Entwicklungsprozesses zu sein und zu testen.

Das ist ja genau so als ob du in nem Restaurant vor dem Ofen stehst in dem die Pizza noch 20 Min brauchst und du sie ständig fragst ob sie schon fertig ist.

Was die Mk II angeht kann ich nix sagen, zur MkIII: Selbst mit einer "langsamen" Karte kann man jetzt full HD Raw aufnehmen ohne Abbruch, Probleme etc. Dadurch dass es durch den Raw Memory Hack mehr Buffer gibt, läuft dieser auch nicht mehr so schnell voll.

Es gibt täglich Updates die man sich ziehen kann, jedes Mal mit einer kleinen Besserung Aber so ist das nunmal, wenn etwas in der Entwicklung steckt.

Antwort von iasi:

na - ein paar Eckdaten sind ja nun bekannt:

- 12Bit wird wohl nichts

- max.65MB/s bei der 5dII

...

http://www.magiclantern.fm/forum/index.php?topic=6215.0

Die 5dIII ist die einzige Canon, die wirklich Raw-geeignet ist - und auch dies eher am Limit, denn etwas Spielraum wäre von Vorteil (1920 sind eigentlich zu wenig.)

Bei 30fps sind ja selbst die 1920 nicht mehr sicher erreichbar.

36x24 sind aus meiner Sicht das einzige Argument, das für den Kauf einer 5dIII zu Filmzwecken spricht,

Die BMCC ist eben eine Alternative - und die befindet sich nicht mehr im Entwicklungsstadium.

Der Workflow ist noch kompliziert - die Bearbeitung in z.B. Photoshop jedoch ein echter Fortshritt gegenüber den H264-Videos.

Antwort von CameraRick:

Produzieren die Canons da eigentlich linear RAW?

Antwort von Valentino:

RAW ist immer linear, da nur die jeweiligen Helligkeitswerte ausgelesen werden. Aus diesem Grund auch die hohe Bittiefe.

Eine A/D Wandlung kann nur linear von statten gehen, so weit ich da jetzt kein Denkfehler habe.

Alles andere wie z.B. das "RAW" der GoPro Hero3 Black ist ja auch nur ein Log Bild in ein AVCHD 8bit 4:2:0 Stream geschrieben.

Deswegen gibt es ja immer wieder die Überlegung ob es den nicht auch schon ein 10bit Log tut.

Antwort von WoWu:

Nee, nee, das ist nicht so ganz so, denn jedes Fotoelement des Sensors erzeugt ja lediglich eine analoge Spannung, deren nachfolgende Quantisierung nach einer beliebigen Kurve erfolgen kann.

Streng genommen könnte sie sogar dynamisch erfolgen.

Es ist eben nur so, dass alle Videokameras zunächst mal nach einer Norm hergestellt werden, SMPTE 240M, die soetwas regelt, (insofern hast Du schon Recht) -wobei auch die Norm bereits nicht wirklich linear ist, (es wird nur immer so genannt).

Aber wer RAW herausgibt unterliegt SMPTE240 sowieso nicht und kann der Quantisierung eine bleibeige Form geben.

Antwort von Valentino:

Ok, aber ist ein digitaler Datensatz nicht immer linear?

Wenn ein Pixel eine maximale Spannung-->Umax hat, dann hat man beim digitalisieren mit 12 bit gleich Xabstufungen=(Umax/4096)-1.

Minus 1, da der erste Werte keine Stufe ist oder?

Einzig die analogen Spannungswerte werden sehr wahrscheinlich nicht linear verlaufen, die digitalisierten Werte ab schon.

Antwort von WoWu:

Es wird nur linear zugeordnet, aber das ist bereits die "Kurve", die dem Wandler mitgegeben wird.

Im Grunde genommen ergibt sich ja daraus erst, welche Dynamic ein Sensor hat, denn das FullWell und die Rauschelektronen bestimmen das ja.

Danach kommt nur noch die Überlegung, wie verteile ich das auf einen (gewollten) Prozessweg.

Denn zwei Sensoren, mit dem identischen Rauschverhältnis können völlig unterschiedliche Dynamik haben. Und U-Max/Umin, verteilt auf die Wertemenge setzt ja noch nicht voraus, dass die Kurve dazwischen linear verläuft.

Die Linearität kommt nur daher, dass die Norm das so vorschreibt.

(Was sie übrigens nicht tut, (linear ist nur eine Variante der Norm) denn schon in den späten 80er Jahren waren 10 Blenden in 8 Bit nicht unüblich und Sony hat schon in den späten 80ern die Log Kurve in den Standard eingebracht).

Logarithmisch kann man also auch unter REC709 arbeiten .... das ist nicht zwangsläufig linear.

Der Standard sagt lediglich, dass für technische Zwecke:

(Schwierigkeiten mit der Aufrechterhaltung der Signalpräzision in umfangreichen Routing- und Verteilsystemen, unvorhersehbares Verhalten von niederfrequenten Transienten, Amplituden und Gruppenlaufzeiten, Video Überschreitungen in inhärenten Coder / Decoder Filterungen usw.) ein Wertebereich freigehalten werden muss.

Was man aber im Wertebereich für eine Quantisierung auflegt, ist eigentlich ziemlich egal.

Also: das lineare Verfahren war eigentlich nie wirklich linear.

Es wurde nur so genannt.

Antwort von chmee:

Die Canon-Raw-Daten aus dem Sensor verhalten sich (im Arbeitsbereich) linear zum Lichteinfall, um es kurz zu sagen. Deswegen ist die Betrachtung "lineare Daten" völlig ok.

RAW-SLR ..wenn man jeden Augenblick mit einer Kernschmelze rechnen muss. :-)

Ist ad Absurdum gestellt worden diese Annahme..

Thema Arri Alexa - Hand aufs Herz, wieviele Produktionen benutzen denn wirklich ARRIRAW? Für einen effizienten Postpro-Ablauf inklusive völlig ausreichender Qualität wird mit 10Bit HDSI auf Aja Ki Pro's ausgespielt..

Wenn mir jetzt etwas am Arbeitsablauf 5DIII-ML_Raw fehlt, dann eigentlich das optimale Format. Jeglicher (Um-)Rechenansatz in der Kamera fällt flach, weil sie nur durch direktes Ausspielen der Sensordaten auf den DMA-Controller und somit den effizientesten Weg auf die CF/SD-Karte gefunden haben, damit der Cache nicht vollläuft und wieder zum Aufnahmestop führt. So war bis jetzt mein Gedanke und die aktuellen Probleme mit der 10- und 12-Bit Umsetzung bestätigen meine Vermutung. Nicht mal so simple Bitshift und Masking-Geschichten sind machbar - woher soll denn dann noch eine Logkurve oder ein anderes Format herauskommen..

Ich hätte wirklich nichts gegen 10bit/log 4:2:2 in einem (von mir aus) H.264-Format mit Bitraten um 150MBit, also irgendwas Richtung Level4.1/High10 - wird aber nix.

mfg chmee

Antwort von Valentino:

Thema Arri Alexa - Hand aufs Herz, wieviele Produktionen benutzen denn wirklich ARRIRAW? Für einen effizienten Postpro-Ablauf inklusive völlig ausreichender Qualität wird mit 10Bit HDSI auf Aja Ki Pro's ausgespielt.

Die Zeiten in den man an eine Alexa eine AJA hängen muss sind schon seit knapp drei Jahren vorbei ;-)

Die Kamera kann intern seit September 2010 ProRes 4444 mit 12 bit auf SxS Karte schreiben.

Seit dem letzten Firmwareupdate sogar in 2k und durch das neue Speichermodul von Codex wird es auch endlich eine Onboard-Raw-Aufzeichnung geben.

Antwort von iasi:

tja - RAW haut eben ziemlich rein - eine Arri Alexa produziert dann auch ordentliche Datenmengen.

Mein bisherigen, kleinen Tests mit meiner 5dII ergaben viele MB für die vergleichweise geringe Auflösung.

Ganz praktisch kommt man daher auch um eine Komprimierung nicht herum, wenn man RAW bei hohen Auflösungen haben möchte.

Bei der ML-Raw-Geschihte ist - zumindest bisher - der Umgang etwas aufwändig ... ein Gewinn gegenüber den bisherigen H264-Videos ist es aber allemal.

WoWo setzt die Latte eben wieder mal sehr hoch an - da gehe ich mit ihm nicht mit. In der Praxis sieht man von der hohen "Latte" in deutschem Kino und TV eh nicht viel.

Vielleicht wäre der umständliche Umgang mit dem ML-RAW-Material sogar förderlich.

Könnte meine 5dII ein wenig mehr an Auflösung, würde ich sie fürs Filmen wieder reaktivieren.

Eine 5dIII zu kaufen ....????

Antwort von WoWu:

@Iasi

Ich leg die Latte gar nicht hoch, nur mein Euphorie-level ist nicht mehr so hoch wie beim Nachwuchs :-)

Es gibt diverse Fragen, die bisher nicht hinreichend geklärt sind, das betrifft in erster Linie mal die Frage, ob die obligatorischen Vorverarbeitungen der Pixel gemacht worden sind. .... keine Antwort

Dann die Frage, woher die Artefakte kommen, die bisher auch hier im Forum so aufgetaucht sind ... (könnte damit zusammenhhaengen) .... keine Antwort

Dann die Frage, wieweit man sich eigentlich auf das hier entstandene DNG Format verlassen kann ... keine Antwort

Und noch ein paar Sachen mehr ...

In der Summe reicht das nicht viel weiter als bis zum Amateurstatus, weit entfernt von einer kommerziellen Nutzung.

Wem's reicht ... prima, wer die Kamera hat, für den ist es sicher ein Zugewinn aber kaufen, oder gar kommerziell nutzen ... weit gefehlt.

Du siehst, die Latte liegt gar nicht so hoch, zumal es reichlich gute und verlässliche Formate für den kommerziellen Einsatz gibt.

Es ist ja nicht so, als würden wir noch Daumenkino machen :-))

Also : wer braucht noch ein weiteres, propietäres Format von der unbekannten Qualität ?

Von Betriebssicherheit brauchen wir gar nicht erst reden.

Antwort von iasi:

@WoWu

Klar ist, was da als RAW herauskommt noch mit sehr vielent Fragezeichen zu versehen.

Aber man muss eben doch auch ganz prakmatisch sehen, dass z.B. in den ML-RAWs noch Zeichnung drin steckt, wo bei den normalen MOVs nichts mehr zu machen war.

Bedenkt man, dass die 5dII in der Vergangenheit schon kommerziell für Filmaufnahmen genutzt worden war, wäre das ML-RAW nochmal ein Schritt nach vorn, würde man sich den Vorteil nicht mit den Nachteilen erkaufen, die die Datenratenbeschränkungen mit sich bringen.

Die 5dIII wiegt immerhin unter einem kg und bietet FF ... zudem ist der Sensor nicht schlecht ...

Antwort von chmee:

@Valentino

Muß? ..Grad erst vor 10 Tagen so erlebt. Ne HDD mit ProRes-Daten, rausnehmen, rüberkopieren, feddich der Lack. Muß diese andere Option unbedingt benutzt werden? Nee, nicht wirklich. Und es war keine Lowbudget-Produktion, sondern eine Equipmentzusammenstellung, wie es dem Cutter am Liebsten ist.

@WoWu

Deine Fragen sind großteilig beantwortbar - Tatsache ist, Du willst einige von den Antworten nicht wahrhaben, weil Deine Skepsis und Dein Anspruch zu groß ist. Manchmal frag ich mich dann aber, wofür der große Anspruch? Because i can?

Vorverarbeitung der Pixel? Da wir von Raw-Daten sprechen, reden wir von Senseln. Das Zusammenfassen zu RGB oder YPbPr-Pixeln inklusive Gamma/Log-Kurve überlässt man somit der Software. Und Software, die mit RAW-Daten umgehen kann, kann auch dies.

Artefakte? Ich bitte um nochmalige Nennung, wenn ich etwas vergesse.

Pink-Highlights? Pink-Fringes? Kein Problem seit ML, sondern seit Jahren bei der Nachbearbeitung von Raw-Daten aus einer Canon-DSLR. google hilft. WENN man im M-Dial-Modus ist UND im Video-Liveview UND DANN den RAW-Videomode nutzt, tritt das Problem nicht auf, da dann der Whitelevel richtig gesetzt ist.

Vertical Lines? Ist nur bei der 5DIII ein Problem, es gibt schon einen Fix (in raw2dng und rawmagic), es ist der erste, der wirklich die Sensel nachjustiert, bevor sie weitergehen - im Rahmen um ~0,4%.

Verlass auf die DNG-Daten? Den Anspruch auf 10 Jahre Garantie setzt nur Du - immerhin sind die Daten so leichtverdaulich, dass es keinen Grund gibt, Angst haben zu müssen. Die Sourcecodes von Magiclantern sind für Alle einsehbar, Du kannst selbst nachschauen, was da wie passiert. Kannst Du es?