Wir hatten schon einmal kurz in einer News darauf hingewiesen, dass sich Photoshops "Generative Fill"-Möglichkeiten auch mit einer kleinen Trickserei auf Bildteile mit bewegten Videoinhalten anwenden lassen. Und so ist das Sommerloch vielleicht die ideale Zeit, das ganze einmal schnell selbst mit einem Workshop in der Praxis auszuprobieren. Vielleicht lässt sich das ganze ja auch noch mit einer virtuellen Zoomfahrt zu garnieren, die beliebig lange dauern kann.

Beta ist (noch) Pflicht

Für diesen Workshop ist bis auf weiteres noch die spezielle, aktuelle Betaversion von Adobes Photoshop aus der Cloud vonnöten, denn in einer finalen Version sind die neuen KI-Funktionen noch nicht zu finden. Alternativ lässt sich dieses Verfahren auch mit Stable Diffusion nutzen, jedoch haben wir den Eindruck, dass unsere Leser eher die Adobe Creative Cloud als Stable Diffusion zur Hand haben. Bein entsprechendem Interesse können wir die notwendigen, alternativen Schritte in Stable Diffusion aber noch in einem eigenen Workshop nachreichen...

Die besagte Funktion in der aktuellen Photoshop Beta nennt sich "Generative Fill" und basiert auf einem generativen KI-Modell, welches maskierte Bereiche in einem Bild schlüssig ergänzen kann. Wie bei Stable Diffusion kann man hiermit nicht nur Objekte löschen oder verändern. Ein Bild kann hiermit ebenso über seinen Rahmen hinaus erweitert werden - indem Adobes KI das präsentierte Bildmotiv optisch "weiterspinnt".

Bei Bewegtbildern funktioniert eine solche Erweiterung allerdings nicht, weil hier für jeden Frame eines Videos ein anderer Inhalt erfunden wird - was die zeitliche konsistente Abfolge der Einzelbilder (zer)stört. Das Video wirkt im besten Falle sehr unruhig, im schlechtesten Fall bekommt man eine Abfolge unzusammenhängender Einzelbilder präsentiert.

Rahmenbedingungen

Was jedoch durchaus funktioniert, ist eine fiktive Rahmenerweiterung, solange die Kameraposition statisch ist - sprich mit einem Stativ aufgenommen wurde. Solange keine Objekte wie z.B. Vögel oder Schatten in den ursprünglichen Rahmen eintreten oder diesen verlassen, kann ein statischer Bereich um das Video "erfunden" werden. Zur Verfeinerung kann man noch mit virtuellen Kamerabewegungen die gefühlte Authentizität erhöhen. Theoretisch lässt sich dabei auch ein beliebig großer Rahmen erfinden, dessen virtuelle Zoomfahrt erst zum Schluss in einem wirklich bewegten Video endet.

Wie das recht einfach funktioniert, wollen wir nun einmal Schritt für Schritt exemplarisch erklären.

Die einzelnen Schritte

Als erstes benötigen wir ein Video ohne Kamerabewegung, das von einem Stativ aufgenommen wurde. Alternativ kann man auch (wie in unserem Fall) versuchen, ein aus der Hand aufgenommenes Smartphone-Video vor dem Einsatz mit einem digitalen Tracker/Stabilizer zu stabilisieren.

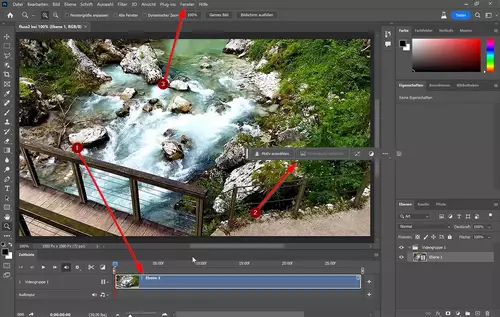

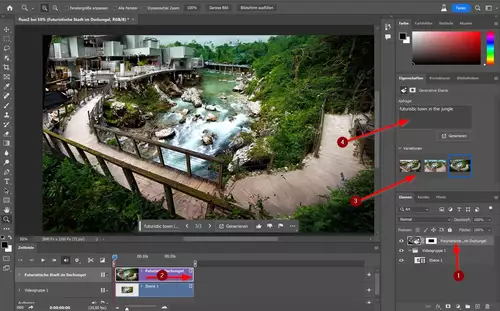

Dieses Video importieren wir in Photoshop als Startprojekt. Anschließend sollten wir eine Zeitleiste (1) sowie eine kontextbezogene Taskleiste (2) sehen. Fehlen diese beiden Elemente, so lassen sich diese im Fenster-Menü (3) aktivieren:

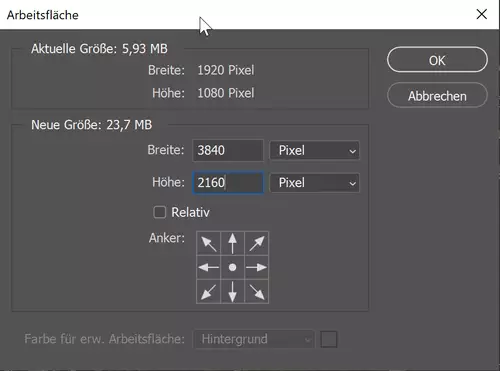

Als nächstes erzeugen wir einen Rahmen um das Bild, in welchem die KI zusätzlichen Bildinhalt "erfinden" soll. Hierfür wählen wir "Bild/Arbeitsfläche..." und geben die Größe für unser finales Projekt ein. Wir wollen für unser Projekt noch eine virtuelle Zoomfahrt realisieren und als finale Ausgabeauflösung FullHD nutzen. Also geben wir eine doppelt so große Arbeitsfläche mit 4K-Auflösung ein:

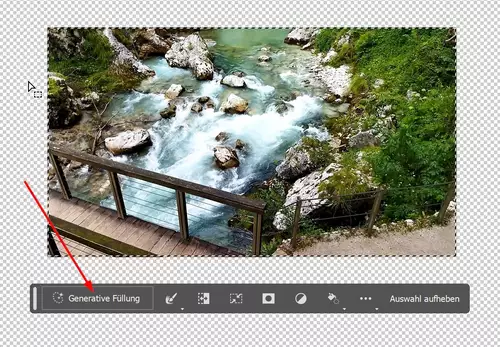

Anschließend wählen wir mit dem Auswahlwerkzeug unser Video aus und kehren unsere Auswahl um, so dass nun die neu hinzugekommene leere Bildfläche selektiert ist. Dann klicken wir in der kontextbezogenen Taskleiste auf "Generative Füllung".

Photoshop fragt uns nun, was wir für Vorstellungen für die "Füllung" haben. Mit diesem Prompt kann man mittlerweile sogar in deutscher Sprache agieren. Wir haben jedoch den subjektiven Eindruck, dass man mit englischen Begriffen meistens bessere Ergebnisse erzielt. Wir haben für unser Beispiel einmal "futuristic town in the jungle" ausprobiert.

Photoshop generiert nun mit seiner KI eine neue Ebene. Diese muss man zur Sichtbarkeit noch über die Videoebene schieben (1) und in der Timeline auf die Videocliplänge anpassen (2). Über das Eigenschaften-Feld lassen sich nun Variationen auswählen (3), löschen, weitere erzeugen und/oder hierfür auch der Prompt verändern (4):

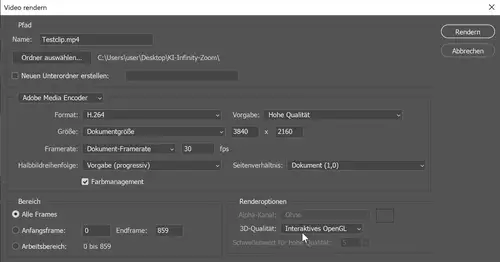

Über "Datei/Exportieren/Video Rendern..." können wir den fertigen Clip in 4K aus Photoshop exportieren:

Der Output

Wenn wir dem Video in einem Editor dann noch durch eine langsame Skalierung über Keyframes eine leichte virtuelle Zoomfahrt auf den Weg geben, kann so ein Shot schon für einige Sekunden recht passabel funktionieren.

Bei längerer Betrachtung fällt dennoch ins Auge, dass hier etwas nicht stimmt. Alleine schon, weil virtuelle 2D-Motion ohne sichtbare Verschiebung der Parallaxen immer etwas "cheesiges" mit sich bringt.

Zoomfahrt durch den Latent Space

Wer dagegen seine Zuseher sowieso überfordern will, kann mit diesem Trick auch Videos immer weiter "stacken" und damit theoretisch unendliche Zoomfahrten realisieren, die am Ende immer auf dem bewegten Original Video "landen". Hierfür lädt man das KI-Video immer wieder in ein weiteres Photoshop-Projekt und lässt sukzessive jedes mal einen weiteren "Rahmen" dazu erfinden. Die Auflösung muss dafür nicht astronomisch steigen, sondern kann konstant bleiben, sofern man später in einer Timeline an den Sprungstellen der virtuellen Zoomfahrt immer ein Video durch das darauffolgende (also früher erzeugte) Video ersetzt: