Newsmeldung von slashCAM:

Grundsätzlich gibt es immer ein NDA-Spannungsverhältnis zwischen Herstellern und der Presse: Der Hersteller stellt unabhängigen Medien Informationen und Testgeräte bereit...

Hier geht es zur Newsmeldung auf den slashCAM Magazin-Seiten:

Hier geht es zur Newsmeldung auf den slashCAM Magazin-Seiten:

Nvidia GeForce RTX 4060 Test - Einfluss auf und durch Influencer?

Antwort von Frank Glencairn:

Und bei Leuten, die zwei Tage vor dem Fall des NDAs im Netz nach Informationen suchen, ergibt sich wahrscheinlich ein weitaus besserer Eindruck als beim Blick auf ein Gesamtfeld aller Tests-Szenarios

Und dann?

Ich bin ziemlich sicher das der tatsächlich Impact dieser Strategie völlig überschätzt wird.

Und wenn ich mir die Specs so anschaue - wär ja ein Wunder wenn die nicht deutlich schneller wäre.

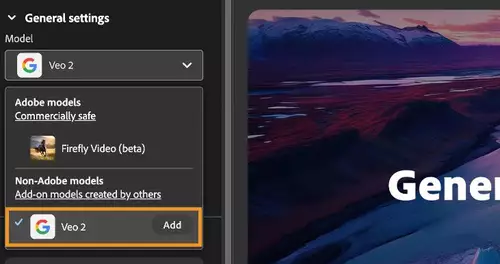

image_2023-06-28_122510545.png

Antwort von rudi:

"Frank Glencairn" hat geschrieben:

Und dann?

Ich bin ziemlich sicher das der tatsächlich Impact dieser Strategie völlig überschätzt wird.

Und wenn ich mir die Specs so anschaue - wär ja ein Wunder wenn die nicht deutlich schneller wäre.

Ähm, die Nvidia-Tabelle lässt ein paar Details aus:

RTX 3060 (12 GB, 192 Bit, 360.0 GB/s)

vs.

RTX 4060 (8 GB, 128 Bit, 272.0 GB/s).

Grade bei der Videobearbeitung dürfte die RTX 3060 schneller sein, da Speicheranbindung oft der limitierende Faktor ist.

Da wir das NDA auch nicht unterschrieben haben, werden wir es leider nicht testen.

Antwort von teichomad:

"RTX 3060 (12 GB, 192 Bit, 360.0 GB/s)

vs.

RTX 4060 (8 GB, 128 Bit, 272.0 GB/s)."

wtf, was geht eigentlich bei nvidia ab.

Antwort von wolfgang:

Also wenn die Kritik die ist, dass nvidia hier Vorab-Tester derart einschränken will, dass diese für nvidia günstige Ergebnisse zeigen - das kann ich mir schon vorstellen. Noch dazu, als die RTX 40xx nicht unbedingt immer der große Vorteile zeigen dürfte (die geringere Speicheranbindung ist wohl schon etwas, was die nicht berichtet haben wollen).

Ich glaube schon, dass diese Einflussnahme auf frühe Tests fragwürdig ist. Denn sucht ein potentielle Käufer, dürfte er wohl eher auf diese "nvidida-freundlichen" tests stoßen.

Es geht halt um Absatzzahlen - und damit Umsätze in einem sehr umkämpften Markt.

Antwort von dienstag_01:

rudi hat geschrieben:

"Frank Glencairn" hat geschrieben:

Und dann?

Ich bin ziemlich sicher das der tatsächlich Impact dieser Strategie völlig überschätzt wird.

Und wenn ich mir die Specs so anschaue - wär ja ein Wunder wenn die nicht deutlich schneller wäre.

Ähm, die Nvidia-Tabelle lässt ein paar Details aus:

RTX 3060 (12 GB, 192 Bit, 360.0 GB/s)

vs.

RTX 4060 (8 GB, 128 Bit, 272.0 GB/s).

Grade bei der Videobearbeitung dürfte die RTX 3060 schneller sein, da Speicheranbindung oft der limitierende Faktor ist.

Da wir das NDA auch nicht unterschrieben haben, werden wir es leider nicht testen.

Wenn ihr Speicheranbindung schreibt, dann meint ihr ja nicht Speichergröße, sondern Transferraten.

Und da würde ich mal nach Adam Ries behaupten, dass bei der 4060 der Speicher schneller "angebunden" ist.

Für 12GB Speichergröße brauche ich 1 Drittel mehr Bandbreite, um den Speicher gleich schnell wie einen 8GB zu füllen. Bei gleicher Transferrate.

Hatten wir doch schon mal bei der, was war das, 970 oder 1070, die hatte bei 6GB auch 192bit. (Wenn ich mich recht erinnere).

Und 360 zu 272 ist weniger als ein Drittel, also 3060 langsamer angebunden.

Antwort von rudi:

dienstag_01 hat geschrieben:

Für 12GB Speichergröße brauche ich 1 Drittel mehr Bandbreite, um den Speicher gleich schnell wie einen 8GB zu füllen. Bei gleicher Transferrate.

Dann hast du aber auch ein Drittel mehr in der gleichen Zeit übertragen.

Nvidia argumentiert übrigens, dass der Cache vom 3 MB auf 24 MB gewachsen ist, und der kann die Bandbreite auf 453 GB/s effektiv erhöhen. Aber leider sind grade bei der Videobearbeitung die Daten selten sinnvoll zu cachen, weil sie so groß sind.

Antwort von Frank Glencairn:

wolfgang hat geschrieben:

(die geringere Speicheranbindung ist wohl schon etwas, was die nicht berichtet haben wollen).

Steht doch groß und fett auf der Nvidia Webseite - die machen da jetzt wirklich kein Geheimnis draus.

Das wär zum ersten mal, daß ein Hersteller die Bandbreite verheimlicht.

Wie kommst du auf sowas?

image_2023-06-28_133039580.png

Antwort von dienstag_01:

rudi hat geschrieben:

dienstag_01 hat geschrieben:

Für 12GB Speichergröße brauche ich 1 Drittel mehr Bandbreite, um den Speicher gleich schnell wie einen 8GB zu füllen. Bei gleicher Transferrate.

Dann hast du aber auch ein Drittel mehr in der gleichen Zeit übertragen.

Nvidia argumentiert übrigens, dass der Cache vom 3 MB auf 24 MB gewachsen ist, und der kann die Bandbreite auf 453 GB/s effektiv erhöhen. Aber leider sind grade bei der Videobearbeitung die Daten selten sinnvoll zu cachen, weil sie so groß sind.

Diese Transferraten sind sowieso theoretischer Natur.

Und wenn es irgendwo hakt, dann doch nicht bei der Transferrate zur Grafikkarte.

Antwort von wolfgang:

Wie kommst du zu einer Tabelle, die das nicht zeigt? Wieso postest du so etwas?

image_2023-06-28_122510545.png

Antwort von medienonkel:

Zum Glück gibt's die 3060ti mittlerweile weit unter 400 Euro. Da hat's dann auch wieder 256bit.

Antwort von Frank Glencairn:

wolfgang hat geschrieben:

Wie kommst du zu einer Tabelle, die das nicht zeigt? Wieso postest du so etwas?

Steht hier - nur halt in GB statt bit - ist doch offensichtlich.

image_2023-06-28_133751249.png

Das hat Rudi ja auch schon oben gepostet.

RTX 3060 (12 GB, 192 Bit, 360.0 GB/s)

vs.

RTX 4060 (8 GB, 128 Bit, 272.0 GB/s).

Antwort von Frank Glencairn:

medienonkel hat geschrieben:

Zum Glück gibt's die 3060ti mittlerweile weit unter 400 Euro. Da hat's dann auch wieder 256bit.

Ich würde vorschlagen wir warten erst mal die Puget Real World Tests ab.

Nach meiner groben Einschätzung wird die 4060 ca.10-15% schneller sein als die 3060.

In AI Modulen wahrscheinlich sogar deutlich schneller sind ja mehr als doppelt so viele Kerne, und auch noch die neueste Generation.

Antwort von pillepalle:

Wenn ich bei meiner 2060 Super nachschaue steht da unter anderem

CUDA-Kerne: 2176

Grafik-Boost-Taktfrequenz: 1650MHz

Speicher-Datenrate: 14.00 Gbps

Speicherschnittstelle: 256-Bit

Speicherbandbreite: 448.06 GB/s

Ist ja sogar besser als bei einer normalen 4060. Aber eine gute Speicherbandbreite kann natürlich nur gewährleisten, dass die Karte dadurch nicht zusätzlich ausgebremst wird. Die Leistung an sich ist natürlich niedriger.

VG

Antwort von wolfgang:

"Frank Glencairn" hat geschrieben:

wolfgang hat geschrieben:

(die geringere Speicheranbindung ist wohl schon etwas, was die nicht berichtet haben wollen).

Steht doch groß und fett auf der Nvidia Webseite - die machen da jetzt wirklich kein Geheimnis draus.

Das wär zum ersten mal, daß ein Hersteller die Bandbreite verheimlicht.

Wie kommst du auf sowas?

image_2023-06-28_133039580.png

Und was willst jetzt von mir? Hatte Rudi erwähnt!

rudi hat geschrieben:

Ähm, die Nvidia-Tabelle lässt ein paar Details aus:

RTX 3060 (12 GB, 192 Bit, 360.0 GB/s)

vs.

RTX 4060 (8 GB, 128 Bit, 272.0 GB/s).

Grade bei der Videobearbeitung dürfte die RTX 3060 schneller sein, da Speicheranbindung oft der limitierende Faktor ist.

Antwort von Frank Glencairn:

Du hast doch behauptet Nvidia würde das angeblich nicht erwähnt haben wollen.

Und daß Rudi in der Liste weder die - ebenfalls groß und fett dastehende - Speicherbandbreite gesehen

hat noch das V-Ram, hat dir offensichtlich auch nicht zu denken gegeben?

Antwort von medienonkel:

"Frank Glencairn" hat geschrieben:

medienonkel hat geschrieben:

Zum Glück gibt's die 3060ti mittlerweile weit unter 400 Euro. Da hat's dann auch wieder 256bit.

Ich würde vorschlagen wir warten erst mal die Puget Real World Tests ab.

Nach meiner groben Einschätzung wird die 4060 ca.10-15% schneller sein als die 3060.

In AI Modulen wahrscheinlich sogar deutlich schneller sind ja mehr als doppelt so viele Kerne, und auch noch die neueste Generation.

Ich meine ja die 3060ti, die von Puget als guter Einstieg ins Workstationsegment geführt wurde/wird.

Die Speicherbandbreite ist ja eigentlich nur bei Echtzeit-Schnitt ein echter limitierender Faktor und wird meinem Eindruck nach auf slashcam zu oft wie eine Monstranz vor der GPU Diskussion hergetragen.

Die Tensor Cores für AI Anwendungen sind natürlich mittlerweile wohl bald wichtiger als Speicherbandbreite oder reine Flops. Zumal man wohl auch bald lokale Optimierungen der Modelle (siehe MS Olive) sehen wird, die dann noch effizienter auf der jeweiligen Maschine laufen.

Man darf auch nie vergessen, dass das hier alles Gaming Karten sind. Hier sollte der vergrößerte Cache durchaus den gewünschten Effekt haben. NVIDIA zählt hier auch sehr stark auf DLSS, was die Framerate in Spielen mittlerweile einfach mal verdoppelt. Dafür sind die Tensor Cores hauptsächlich gedacht.

Man geht auch langsam dazu über Raytracing und GI durch AI ergänzen zu lassen.

https://www.youtube.com/watch?v=KFsfv-BL0N0&t=183s

Vielleicht sieht man in Zukunft auch tatsächlich eher eine Stagnation der rohen Geometrie- und Texturleistung bei GPUs, die dann nur noch eine Art genormte Bildvorgabe rendert, die dann von höchst optimierten Netzen zur eigentlichen Spielegrafik komplettiert werden. Fände ich sehr interessant, so könnte sich auch hier immer mehr die Bildqualität Richtung Software verschieben.

Ansätze z.B. GTA Fotorealistisch darzustellen gibt es ja schon länger.

https://www.youtube.com/watch?v=P1IcaBn3ej0

Antwort von Frank Glencairn:

medienonkel hat geschrieben:

Die Speicherbandbreite ist ja eigentlich nur bei Echtzeit-Schnitt ein echter limitierender Faktor und wird meinem Eindruck nach auf slashcam zu oft wie eine Monstranz vor der GPU Diskussion hergetragen.

Ja, vor allem wenn man bedenkt, daß selbst auf unserer ältesten Workstation mit ner quasi antiken 4 GB GTX980 flüssiger Echtzeitschnitt ohne irgendwelchen Cachereien möglich ist.

Antwort von MK:

Selbst mit PCIe 5.0 x16 kann man nur ca. 63 Gigabyte pro Sekunde übertragen... von daher wird die interne Speicherbandbreite der Grafikkarte für Videobearbeitung am Ende... egal... sein...

Antwort von jjpoelli:

Also ihr sagt, ich soll bei unseren GTX 1080 bleiben die alles ermöglichen nur bei Fusion-Effekten nur noch 5-8 fps schaffen?

(ist ernst gemeint weil ich schon gedacht hab ich sollte vielleicht upgraden....)

Antwort von medienonkel:

jjpoelli hat geschrieben:

Also ihr sagt, ich soll bei unseren GTX 1080 bleiben die alles ermöglichen nur bei Fusion-Effekten nur noch 5-8 fps schaffen?

(ist ernst gemeint weil ich schon gedacht hab ich sollte vielleicht upgraden....)

Die Frage kannst nur du dir selbst beantworten.... ob Fusion mit einer neuen GPU wirklich schneller läuft hängt auch stark von den von dir verwendeten Effekten/Filtern ab.

Wenn du viel mit Fusion-Effekten machst könnte es sich also lohnen.

Aber nicht unterschätzen, dass auch die CPU das Upgrade leistungstechnisch unterstützen können muss.

Antwort von medienonkel:

Gerade aufgeschlagen:

https://www.youtube.com/watch?v=O0srjKOOR4g

Antwort von macaw:

Was für eine dämliche Strategie soll das denn sein? Diejenigen, die eine GPU so derart völlig überstürzt kaufen, dürften eh nur Gamer mit zuviel Geld und zuwenig Geduld sein. Die meisten dürften nach den Überraschungen der letzten Jahre eh abwarten, bis die Treiber einigermaßen sauber oder technische Probleme wie die mit den billigen Kondensatoren der 30er Serie oder den geschmolzenen Kabeln der 40er Serie korrigiert/geklärt sind. Ganz zu schweigen davon, daß viele das Sacken der Preise und in Ruhe durchgeführte Tests mit vielen verschiedenen Spielen, Programmen, Konfigurationen und Settings abwarten.

Antwort von Frank Glencairn:

Eben - irgendwelche First Person Shooter FPS interessieren mich sowieso nicht die Bohne und beim einzigen Test der nicht nur für Spielkinder interessant ist (Blender) war sie auf dem zweiten Platz unter der TI.

Ned schlecht für ne 299,- Stromsparkarte.

Is ja noch nicht so lange her, da hat man für weniger Leistung 1200,- gezahlt.

Wie ich schon sagte, lass die mal ihre Treiberprobleme sortieren, und dann sehen wir uns die Puget Tests an, mit Ergebnissen die auch tatsächlich für unsereins relevant sind.