Newsmeldung von slashCAM:

Wie einfach und doch wirkungsvoll inzwischen verschiedene KI-Tools im Zusammenspiel eingesetzt werden können, um interessante Effekte in Videos zu realisieren, hatte kürz...

Hier geht es zur Newsmeldung auf den slashCAM Magazin-Seiten:

Hier geht es zur Newsmeldung auf den slashCAM Magazin-Seiten:

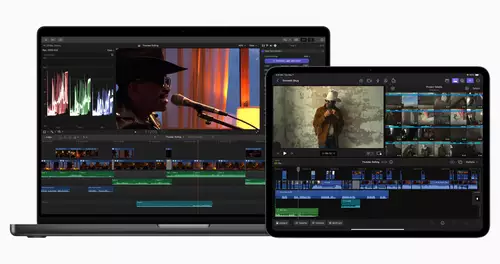

VFX leicht gemacht: mit KI Gesichter animieren und Stimmen synthetisieren

Antwort von -paleface-:

Ich sag ja...noch 10 Jahre dann läuft alles auf Knopfdruck.

Antwort von patfish:

Da Face replacement ein extrem aufwendiges Verfahren ist, die Bewegung/Animation der Muskel extrem komplex ist und wir Menschen aus täglichen Training jede kleine Unnatürlichkeit sofort bemerkten (uncanny), hat KI hier tatsächlich einen großen Vorteil. Einzig, um wirklich 100 % realistische, hochaufgelöste Modelle (z.B. für Hollywoodfilme) anzutrainieren, braucht es eine riesige und hochqualitative Datenbank an Referenzfototage und enorm viel Rechenkapazität. Dafür spart man sich aber Motion Capture und viele CG Artists.

Bei klassischen VFX Tasks wie Rotoscoping, Keying, Inpainting, Cleanplates usw. sind die aktuellen KI-Tools aber noch nicht ausgereift genug, um hochwertigen VFX-Projekten zu genügen. Speziell die manuelle Kontrolle über den Output muss noch viel zugänglicher werden. Das ist generell, der Punkt an dem noch am meisten geforscht und entwickelt werden muss!

Aja, und Ebsynt ist kein KI Toll! Das setzt auf klassische Optical Flow Algorithmen.

Antwort von medienonkel:

Ich frage mich auch, wie man in stable diffusion konstant passende keyframes erzeugt. Selbst bei neutralem Hintergrund und betonierter Kadrierung, konstantem seed und unangetasteten settings/prompt kommt 100 frames später ganz was anderes raus.

Wie patfish ja schon sagte hat ebsynth nichts mit KI zu tun. Bei relativ statischem Gesichtsausdruck kann die Methode so klappen, sobald aber größere Mimik dazu kommt, geht das Glitchen los.

Da wäre entsprechendes deep faking eher angebracht. Gibt's ja auch schon seit... Jahren.

Und auch schon für full body faking.

Trotzdem hat er sehr kreativ die tools genutzt. Aber auch gleich die aktuellen Einschränkungen gezeigt.

Antwort von roki100:

https://www.youtube.com/watch?v=Jr8yEgu7sHU

Antwort von Darth Schneider:

Viel echter, irgendwie doch, wirklich fast wie der Elvis, zumindest das Bild, nur wenn er singt…;)

Gruss Boris